Arquivo da categoria: EPISTEMOLOGIA

QUEM SOMOS NÓS – NA VISÃO DOS FÍSICOS E FILÓSOFOS, NÃO DOS MÍSTICOS.

_______________________________________________________________________________________

Abaixo, temos um link da WIKIPÉDIA que traz uma análise bastante esclarecedora sobre o filme

“What the Bleep Do We Know!?”:

<https://pt.wikipedia.org/wiki/What_the_Bleep_Do_We_Know!%3F>

________________________________

ATENÇÃO!

Aqui, nosso objetivo não é validar o filme em termos científicos, mas utilizá-lo como ilustração para a discussão da Teoria Quântica.

__________________________________

………………………………………………..

………………………………………….

INTRODUÇÃO

Medidas Históricas

…………………………………………..

…………………………………………………….

Importante verificarmos dois fatos históricos fundamentais à critica do filme “Quem Somos Nós?”. O primeiro se deu ainda na Antiguidade quando Parmêncides e Heráclito discutiam sobre o MOVIMENTO. O segundo ocorreu quando da criação da MECÂNICA QUÂNTICA. Ambos os fatos históricos se relacionam com o problema da MEDIDA na matemática e na física.

____________________________________________________________

_____________________________________

____________________________________________________________

_____________________________________

É sabido de todos, quando na época da Grécia Antiga, os pitagóricos detinham nas mãos uma poderosa ferramenta matemática capaz de modelar a Natureza. Assim eram capazes de tratar com quase todos os fenômenos materiais usando apenas números.

Entretanto, foi utilizando e pesquisando tais modelagens numéricas que os pitagóricos se depararam com a impossibilidade de representar o movimento usando a teoria dos números: a descoberta do infinito nas medidas se estabeleceu, então, como uma grande dificuldade a ser vencida quando da representação matemática do movimento. E os pitagóricos esconderam esse fato durante muito tempo. Daí, portanto, com a medida ôntica da hipotenusa no Triângulo Retângulo Isósceles, o Mundo Grego Antigo desabou.

Todavia, confirmando o pensamento eleata, Platão – através da Segunda Navegação -, buscando completar e justificar o pensamento de Parmênides, postulou, assim, a existência do Mundo das Ideias, no qual residiria a verdadeira realidade: sendo o Mundo no qual vivemos, apenas uma projeção da sombra desse mundo ideal. Como vemos, toda essa reviravolta na visão que o homem antigo tinha do Universo foi causada pela simples descoberta do INFINITO nas medidas, ou seja, os incomensuráveis. Assim, a matemática grega incapacitada de lidar com tais medições, favoreceu a ruína da Visão de Mundo dos pitagóricos a qual era vigente naquela época. Daí por diante, Platão, tentando por ordem na “casa”, fez nascer o mundo das Ideias, estabelecendo a dicotomia entre Idealistas e Materialistas.

Hoje, novamente por conta de um problema de medida, envolvendo as medidas da posição e do momento do elétron nos fenômenos quânticos, temos uma nova reviravolta, agora com relação a Visão de Mundo consagrada pela comunidade científica atual, fundada na Física Clássica. A partir dessa medida, se gerou uma nova visão dada pela Mecânica Quântica, donde se sugere que a dicotomia, elaborada por Platão e reafirmada por Descartes, seja anulada, ou seja, não há separação entre sujeito e objeto.

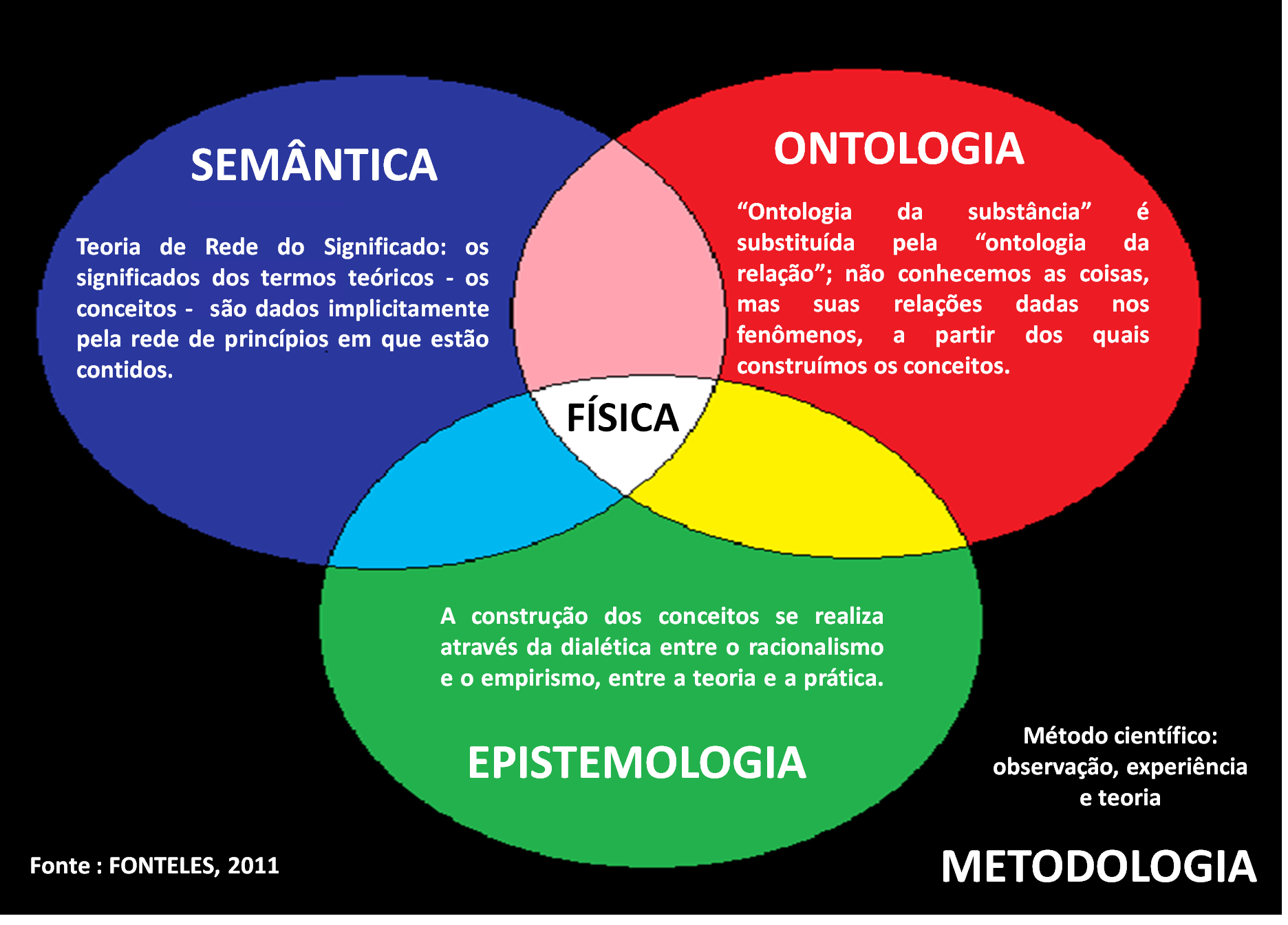

Tendo em vista, assim, a importância da problemática da medida dos quanta, aprofundamos abaixo uma discussão ontológica, e epistemológica, semântica e metodológica sobre o conhecimento da ciência física, de modo a propiciar uma critica justa e esclarecedora do afamado filme “QUEM SOMOS NÓS?”.

…………………………………………………

………………………………………….

FÍSICA

Ontologia

Epistemologia

Semântica

Metodologia

…………………………………………..

…………………………………………………….

.____________________________________________________________

.____________________________________________________________

_____________________________________

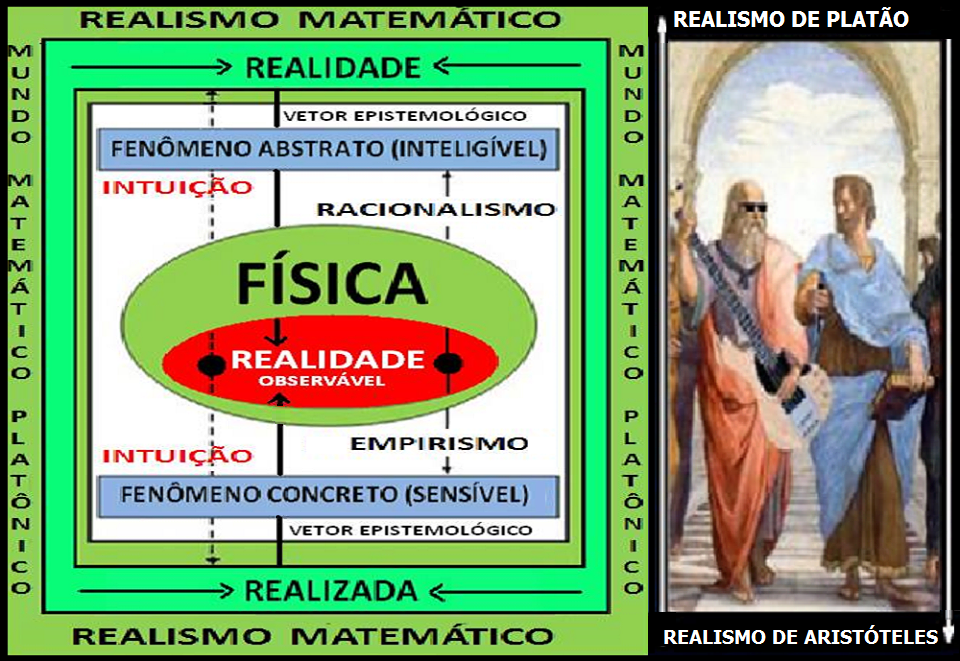

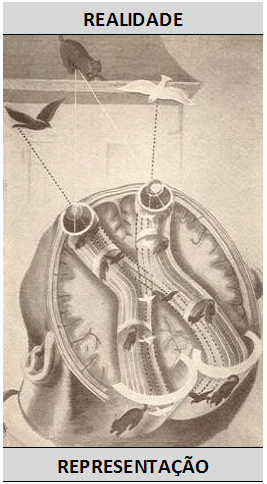

No diagrama acima, fazemos uma abordagem do conhecimento da Física Moderna segundo os pontos de vista ontológico, epistemológico, semântico e metodológico:

– Ontologicamente, então, dizemos que a Física não conhece em si os objetos de seu estudo, mas suas relações, as estruturas matemáticas na qual estão inseridos. Ignorando, assim, a realidade, a Física toma contato apenas com os fenômenos (o observável) a partir dos quais constrói seus conceitos.

– Semanticamente, os significados dos termos teóricos (conceitos), são dados implicitamente pela rede de princípios ou significados na qual estão contidos, ou seja, um conceito como o de campo eletromagnético somente pode ser descrito ou entendido dentro da rede significados da teoria eletromagnética. O que seja o campo em si, a coisa-em-si, a ciência física desconhece e não tem interesse em conhecer;

– Epistemologicamente, a construção dos conceitos físicos se dá através da dialética entre o racionalismo e o empirismo, entre teoria e prática. Assim, a partir do momento em que se medita na ação científica, apercebemo-nos de que o empirismo e o racionalismo trocam entre si infindavelmente os seus conselhos. Nem um e nem outro, isoladamente, basta para construir a prova científica. Contudo, o sentido do vetor epistemológico parece-nos bem nítido: vai seguramente do racional ao real e não, ao contrário, do real ao racional, como o professavam todos os filósofos de Aristóteles a Bacon. Em outras palavras, a aplicação do pensamento científico parece-nos essencialmente realizante (BACHELARD, 1978).

– Metodologicamente, a Física observa os fenômenos através de experiências, experimentalmente bem elaboradas, analisa as propriedades físicas presentes nestes fenômenos e – conseguindo isolar as principais grandezas envolvidas -, procede a matematização destas elaborando, então, as leis fenomenológicas e as teorias fundamentais: aplica, assim, inexoravelmente, o método científico no seu trabalho de pesquisa.

De acordo com tal diagrama, todo conceito da Física só é bem explicado e compreendido dentro de sua semântica: ou seja, os fatos ou fenômenos nos dão apenas uma pista no sentido de entendermos as estruturas intrínsecas à realidade que exprimem. A partir daí – sempre que necessário – como num círculo vicioso, novamente e sempre, passamos à construção de novos conceitos, servindo-nos da dialética entre o racionalismo e o empirismo a qual na prática faz uso do método científico.

Com o advento da Mecânica Quântica, passou a imperar na Física um forte antirrealismo dado a constatação de certos paradoxos no lidar com os fenômenos quânticos. Tais, paradoxos, como veremos, faz perder o sentido a discussão entre idealistas e realistas.

____________________________________________________________

____________________________________________________________.

Paul Dirac

(Göttingen, 1982)

____________________________________________________________

____________________________________________________________.

No estudo da Física, a composição do Universo é dividida em duas entidades – matéria e energia. De acordo com o método científico, devemos realmente admitir que pode haver no Universo algo mais além da matéria e da energia, mas até agora a Física não encontrou este terceiro componente. A matéria inclui os materiais que formam o Universo: as rochas, a água, o ar e a multiplicidade de coisas vivas. Tudo que é sólido, líquido ou gasoso é uma forma de matéria.

Mas, classificar algo como MATÉRIA não significa, entretanto, que conheçamos a natureza real da matéria. O químico desdobra a matéria para determinar seus constituintes e o físico deseja saber o que mantém tais constituintes unidos; mas as partículas fundamentais e as leis da matéria parecem ser sempre um desafio.

A melhor maneira de adquirir um conceito de matéria é trabalhar com ela e descrever suas formas. Uma descrição não é uma definição no sentido real da palavra, mas reduz uma IDEIA ABSTRATA a termos bem concretos. As propriedades da matéria são usadas para descrever a matéria: na verdade, é mais fácil discutir a matéria em termos de suas propriedades do que explicar a sua natureza final.

A ENERGIA, então, é ainda mais difícil de definir que a matéria. Ela não tem peso e só pode ser medida quando está sendo transformada, ou ao ser liberada ou absorvida. Por isso, a energia não possui unidades físicas próprias, sendo expressa em termos das unidades do trabalho que realiza.

____________________________________________________________

____________________________________________________________………………………………………….. …………..

…………..

Só quem bem compreende a natureza da ciência, poderá com proveito e prazer, e sem perplexidades, aplicar-se aos estudos científicos. Ciência não é coleção de conhecimentos nem busca da verdade absoluta, mas sim formação de conceitos (ao descrevermos o domicílio do homem no universo, nos utilizamos de vários deles). A Física não conta fatos, pois os seus termos: massa, energia, velocidade, não são realidades, e sim os conceitos fundamentais da Física, como, aliás, muito bem se diz, mas que freqüentemente nos escapa durante a leitura.

Os conceitos, então, são instrumentos do pensamento, artificialmente construídos, tais, como as chaves de parafusos, são instrumentos que servem para abrir um motor, o qual nada tem a ver com chaves de parafusos; são escadas, pelas quais subimos a uma casa eternamente fechada.” (KAHN, 1963).

____________________________________________________________

____________________________________________________________

Não obstante, tendo em vista a semântica da física, na visão dos físicos, o Universo é constituído por partículas elementares subatômicas que se atraem e se repelem mutuamente por meio de campos de força. No entanto, as principais unidades da TEORIA QUÂNTICA DE CAMPOS não se comportam como bolas de bilhar. Isso quer dizer que, quando analisamos a constituição do mundo pela visão da teoria quântica de campos, nem partículas nem campos são fundamentais. Isso nos leva ao seguinte questionamento: O QUE É ESSENCIAL?

A busca pelo que é essencial ou pela essência das coisas é metafísica e foi deixado de lado pela ciência moderna. A partir do século XVII, o traço característico e fundamental da ciência natural exata – dita, aqui, fragmentária e parcial -, é a experiência analítica: esta decompõe em seus elementos, muitas vezes invisíveis, os fenômenos pré-científicos e cotidianos, para depois novamente reuní-los. Porém, esta tendência moderna para a análise segue, antes mais nada, a construção de aparelhos e seu uso para observações sempre mais exatas. Mas, o esforço para ser exato pressupõe um grande interesse por constatações numéricas exatas, o que leva a pesquisa numa direção inteiramente nova. De tudo isto resulta que a experiência analítica e a análise matemática estão em íntima relação e tal se expressa pelo fato de em ambas se traduzir na tendência construtiva da ciência moderna: aqui a Física se afasta da metafísica, deixando de buscar a concepção ontológico-substancial da realidade.

Nesta linha de raciocínio, podemos afirma que cientificamente falando: a física não sabe o que é matéria; a biologia não sabe o que é vida; a matemática não sabe o que é número; a informática não sabe o que é informação; a psicologia não sabe o que é alma; enfim, o que se sabe são as propriedades correspondente de cada objeto de estudo, específico para cada ciência. O que seja a coisa-em-si, como já foi dito, é uma área de estudo da metafísica.

Nesta construção da ciência moderna, eis que surge a ideia do “forçamento” (ou violação) da Natureza pelo homem através do método científico; ideia que é uma consequência, senão um pressuposto, da técnica moderna. Este forçamento, entretanto, se deu por conta do papel desempenhado pelo pensamento matemático. Ou seja, é por meio de tal pensamento que se torna possível a pesquisa analítica dos fenômenos naturais, sua decomposição em processos simples e controláveis em suas causas, e assim a construção de aparelhos tecnicamente mais perfeitos do que era capaz de produzir a cultura antiga que “nascia” da Natureza. Foi preciso antes de tudo destruir e decompor os conjuntos naturais para conseguir que as forças da Natureza agissem segundo a vontade do homem.

Este forçamento, entretanto, patrocinado pelo pensamento matemático, só se tornou possível pela “renúncia”, ou seja, pela eliminação da metafísica. No século XX, a questão de como fundamentar o uso da matemática na ciência levou ao “positivismo lógico” (Viena: M. Schlick, R. Carnap) e ao “empirismo lógico” (Berlim: H. Reichenbach). Tal atitude se inicia com o aforisma de Francis Bacon: Naturam renuntiando vincimus – pela renúncia vencemos a natureza. Assim, por mais paradoxal que pareça, o processo para arrancar à natureza seus mistérios e pôr suas forças a nosso serviço, se realiza renunciando ao conhecimento de sua “essência“. Aqui está o ponto em que a maneira especificamente matemática de pensar desempenhou seu papel: a “renúncia” tem por consequência uma limitação de respostas possíveis sobre a natureza. Em muitos casos esta limitação, a impossibilidade de dar diversas respostas, se deixa precisar matematicamente. Resulta daí que as possibilidades estruturais de formular matematicamente as leis da natureza são igualmente limitadas. A fórmula é sempre determinada e, em casos extremos, absolutamente imutável. Não é como se somente o processo, e não a causa, de um fenômeno fosse representável pelos meios matemáticos, mas que outros conhecimentos a que se renunciou podem ser conhecidos positivamente por métodos matemáticos.

Ontologicamente, à Física Moderna faz-se necessário um novo realismo: o realismo, não de objetos, mas de estruturas. Assim, alguns físicos teóricos, portanto, sugerem que basicamente o mundo é constituído de relações ou propriedades. Tal posição, em que as relações são tudo que existe e as propriedades possuem existência real, é chamada de REALISMO ESTRUTURAL ÔNTICO:

“Não conhecemos os objetos, mas suas relações, suas propriedades, suas estruturas, ou seja, ignoramos o que seja a realidade em si, e, tomando contato somente com os fenômenos, construímos os conceitos. A ontologia da substância é substituída pela ontologia da relação.”.

…………………………………………..…….

………………………………………….

MECÂNICA QUÂNTICA

Ortodoxia

…………………………………………..

…………………………………………………….

_____________________________________

É bastante provável que na história do pensamento humano os desenvolvimentos mais fecundos ocorram, não raro, naqueles pontos para onde convergem duas linhas diversas de pensamento.

_____________________________________

Werner Heisenberg

________________________________________

_____________________

Os debates em torno dos fundamentos da mecânica quântica, constituíram-se em uma perene controvérsia filosófica e científica, desde o surgimento da teoria em 1926 até os dias de hoje. Nas primeiras décadas, tais debates se restringiam ao círculo de cientistas e matemáticos que participaram do estabelecimento das bases conceituais e formais da teoria, tais como Niels Bohr, Werner Heisenberg, Erwin Schrödinger, Albert Einstein, Wolfgang Pauli, Max Born e John von Neumann, entre outros. O resultado disso foi a consolidação da interpretação ortodoxa da teoria quântica, de cunho ANTIRREALISTA, articulada especialmente por Bohr.

____________________________________________________________

Solvay Physics Conference 1927

____________________________________________________________

O modelo atômico de Bohr – estrutura mecânica construída sobre fundamentos “mais ou menos clássicos” -, não pôde explicar a razão da existência de certas órbitas permitidas (ou orbitais) em torno do núcleo atômico. A teoria da mecânica ondulatória de Erwin Schrödinger foi a primeira sugestão radical duma solução para as dificuldades fundamentais do modelo de Bohr. Entretanto, esse físico austríaco defendia que todas as coisas poderiam, na “realidade”, ser representadas por ondas multidimensionais. Ainda que as equações diferenciais de Schrödinger para a descrição dos fenômenos subatômicos fossem muito aceitos pelos físicos, a sua interpretação geral não o era.

____________________________________________________________

POTÊNCIA E ATO DE ARISTÓTELES.

____________________________________________________________

Para Aristóteles, ALGO pode existir ora como ato, ora como potência. Uma semente, por exemplo, é ato enquanto semente, mas é árvore enquanto potentia. O ato, portanto, é a existência concreta, a concordância ontológica daquilo que é como de fato é, e a potência é também uma existência tão real quanto o ato, mas é existência daquilo que está presente no ato enquanto suas possibilidades. Ou seja, a existência da árvore na semente é uma existência real, porque a árvore é uma potência real da semente, um desdobramento natural da mesma, seu fim, sua consequência. A árvore já está ‘contida’ na semente, e, portanto não existe enquanto ato, mas é real, na medida em que existe enquanto potentia. Analogamente, os objetos quânticos, mesmo que não possam ser medidos e localizados, mesmo que pareça não existir concretamente, são reais porque existem enquanto possibilidades, probabilidades, potências elementares da natureza. Assim, durante o salto quântico o elétron existe enquanto possibilidade de ser, potentia de vir a ser.

Analogamente, segundo Heisenberg, na teoria quântica todos os conceitos clássicos – quando aplicados ao átomo – encontram-se tão bem ou tão mal definidos como o de temperatura de um átomo: eles estão correlacionados com certas expectativas estatísticas acerca das propriedades atômicas; somente às instâncias raras, a expectativa, isto é, a probabilidade correspondente, equivalerá à certeza. E, de novo, como no caso da termodinâmica estatística clássica, é difícil considerar-se essa expectativa como algo objetivo. Talvez se possa chamá-la de tendência ou possibilidade objetiva, uma potencialidade, a potentia no sentido da física aristotélica. De fato, a linguagem que os físicos utilizam, ao falar sobre fenômenos atômicos, sugere em suas mentes algo semelhante ao conceito de potentia. E os físicos, assim, foram gradualmente se habituando a falar, por exemplo, de órbitas eletrônicas, não como uma realidade, mas sim como uma potentia.

A ideia de Heisenberg é a de que existem dois modos de realidade. A realidade enquanto coisa objetiva, que pode ser mensurada, e a realidade enquanto potentia, que pode apenas ser pensada abstratamente e instrumentalizada pelo mais profundo formalismo matemático da física quântica. Os objetos quânticos, ao contrário dos clássicos, são potentias neste sentido. Podemos afirmar que existem, mas existem neste modo: enquanto possibilidades objetivas e não como objetos ou eventos mensuráveis, que perdura determinado tempo em alguma parte do espaço.

Do mesmo modo, a filosofia que se encontra por trás do dualismo onda-corpúsculo, estabelece que a interpretação dos resultados depende do tipo de experiência que é realizada. Essa linha produtiva de raciocínio foi iniciada por Niels Bohr. Foi ele o primeiro a reconhecer que era impossível sujeitar à observação simultânea os dois aspectos distintos do elétron, ou seja, o seu caráter de onda e o de corpúsculo. Esse é um princípio limitador que governa as condições experimentais e limita a informação que pode ser obtida das experiências.

____________________________________________________________

____________________________________________________________

Prof. José Evangelista de Carvalho Moreira (UFC).

____________________________________________________________

____________________________________________________________

Essa ideia está expressa compreensivelmente no Princípio de Complementaridade de Bohr. Em toda a filosofia da ciência, esse conceito elaborado de forma teórica é, seguramente, a contribuição mais importante depois da publicação, por Immanuel Kant, da Crítica da Razão Pura em 1781 (e a segunda edição, revista, de 1787). Esse trabalho do filósofo de Könisberg é a revisão de maior autoridade da Física do seu tempo – a Física Newtoniana. Quando essa teoria clássica começou a falhar na explicação dos fenômenos subatômicos, o primeiro passo corajoso no sentido de introdução de conceitos novos foi dado por Niels Bohr. Além dele, o jovem físico alemão Werner Heisenberg conseguia, na segunda metade da década de vinte, obter uma compreensão mais clara da nova situação da física. Adotou então uma atitude filosófica baseada no extremo empiricismo, que recusava aceitar quaisquer das imagens ou modelos da física moderna. Por exemplo, no modelo atômico de Bohr, os físicos se referiam à “posição” e ao “período de revolução” de um dos elétrons do átomo. Essas noções formavam uma herança da mecânica newtoniana e, em relação aos elétrons atômicos, eram classificadas como “não-observáveis”. Heisenberg considerou essas “noções imaginárias” como sendo algo sem sentido, desprovido de qualquer fundamento.

Entretanto, muito surpreendia a Heisenberg as ideias matemáticas de Platão sobre a matéria: reduzidas a conceitos matemáticos, tais ideias platônicas se coadunavam com a teoria matemática de Heisenberg sobre as partículas subatômicas.

____________________________________________________________

____________________________________________________________

A TEORIA “PITAGÓRICA” DE PLATÃO SOBRE A MATÉRIA

________________________________________________________________________________

“O termo ‘elemento’ (do grego stoicheia) foi cunhado pela primeira vez por Platão em 360 a.C. em seus diálogos com outro filósofo grego, Timeu de Lócrida, onde discursa sobre a composição dos corpos orgânicos e inorgânicos, considerada atualmente como um tratado rudimentar de química. Platão compôs sua teoria física baseando-se em um modelo geométrico, ao perceber que uma teoria sobre a natureza de caráter puramente aritmético era impossível, sendo preciso um novo método matemático para a descrição do mundo. Desse modo, elaborou um método geométrico que veio até mesmo a influenciar Euclides. A teoria platônica propôs uma versão geométrica para a teoria atômica de Demócrito, usando o triângulo como o elemento básico de seu modelo de partículas elementares, construindo a partir dele os sólidos geométricos. Cada elemento de Empédocles foi associado a um sólido geométrico na forma de partícula; assim, o cubo fora associado à terra por ser o mais imóvel dos quatro elementos, seguido pela ordem da estabilidade: o icosaedro à água, o octaedro ao ar e o tetraedro ao fogo. Nesta teoria dos quatro elementos Aristóteles acrescenta, em torno de 350 a.C., um quinto elemento ou “quintessência”, que formaria os céus, representado pelo dodecaedro. Com base nesta lógica, vários pensadores especularam ao longo dos dois mil anos seguintes sobre as formas geométricas possíveis, como os círculos, quadrados, polígonos, etc., (ou seja, os elementos) e como essas formas poderiam se combinar, se repelir, ou interagir umas com as outras para criar novos elementos.

“Aqui, o que diz, o eminente físico teórico W. Heisenberg, a respeito dos triângulos elementares de Platão: “Os triângulos não são matéria, mas são simples formas matemáticas, e a questão do porquê dessas partículas elementares é reduzida por Platão à matemática. As partículas elementares têm a forma que lhes é atribuída por Platão porque tal é a forma mais bela e mais simples. A última causa dos fenômenos, portanto, não é a matéria, mas a lei matemática, a simetria, a fórmula matemática”. E Heisenberg explica por esta mesma tendência à simetria sua própria teoria sobre as partículas elementares hoje conhecidas, por mais que no decurso de mais de dois milênios se tenha modificado a posição da física. Com a descoberta, feita por Planck, dos quanta energéticos, de novo entrou na ciência natural a ideia platônica “que na base da estrutura atômica da matéria está em última análise uma lei matemática, uma simetria matemática.” (Oskar Bexker)

____________________________________________________________

____________________________________________________________

Heisenberg, então, sugeriu um novo programa para o desenvolvimento de uma MECÂNICA QUÂNTICA TEÓRICA, análoga à mecânica clássica, na qual apareceriam apenas relações entre quantidades observáveis:

Este conceito foi introduzido na Física e, em especial, na Mecânica quântica, por Dirac. Na Física clássica, a possibilidade de observação de uma propriedade física se admite a priori, porém não ocorre o mesmo em Mecânica quântica. Em Mecânica clássica uma variável dinâmica, relativa a qualquer estado físico de um sistema físico, vem dada como uma função definida no tempo. Tal variável, assim, pois, determinada, é, portanto, medível em qualquer instante. Em Mecânica quântica, o dualismo onda-corpúsculo faz com que isto não seja possível. Um sistema elementar aparece ora como onda, ora como partícula; quer dizer, algumas vezes observamos propriedades ondulatórias e outras vezes propriedades corpusculares. Num mesmo instante, não podemos efetuar ambos os tipos de observações: uma observação exclui a outra. Chama-se observável uma magnitude tal que é medível em um instante determinado. A descrição de uma observação no domínio da Mecânica quântica é a mesma que na Física clássica: a observação proporciona um número, como resultado da medição. Na Física clássica, se pode seguir o curso temporal de um acontecimento mediante uma sucessão de observações; porém não se pode fazer assim na Mecânica quântica, pois no domínio da microfísica cada medição modifica o estado do objeto e a forma em que aparece. Portanto, depois de uma medição, deveria recobrar-se o estado inicial antes de poder efetuar-se uma segunda observação. Naturalmente, o resultado desta segunda medição depende de uma maneira direta da primeira medida.

São observáveis, por exemplo, a posição, o impulso, a energia, o spin, porém não são observáveis os estados que são representados pela função Ψ.

A magnitude matemática que representa um observável, precisamente não é um simples número, mas sim um operador. Porém os operadores só podem considerar-se como números dentro de certos limites. Assim, nem todo operador é comutativo ou permutável quanto à multiplicação; por exemplo, o operador de spin é anticomutativo. Nestes casos se fala também de observáveis anticomutativos (ou, bem, de operadores comutativos ou permutáveis).

____________________________________________________________

____________________________________________________________

A filosofia EMPIRISTA – INDUTIVISTA, ainda presente na Física e na ciência em geral, precisa ser substituída por uma visão filosófica mais contemporânea, que ajuda o cientista a ser mais crítico e criativo.

_________MÁRIO BUNGE__________

____________________________________________________________

____________________________________________________________

Heisenberg rejeitava, portanto, o conceito de órbitas eletrônicas com raios definidos e períodos de revolução, porque esses não eram observáveis, e recomendava que fosse construída uma matemática que desse conta dos fenômenos observados, dos observáveis.

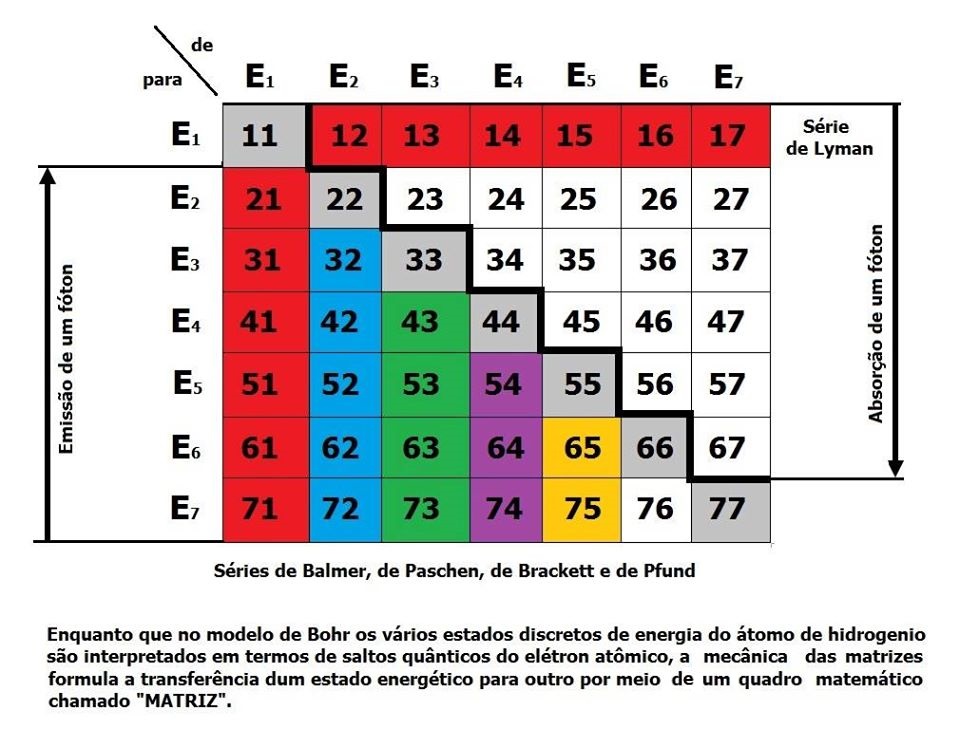

A realização desse programa formava o que se conhece como “Mecânica das Matrizes”, e foi aperfeiçoado com a colaboração do professor de Heisenberg, Max Born, e de Pascual Jordan.

Tudo começou quando “afortunadamente” em 1925, acometido de febre do feno, Heisenberg tirou uma licença de duas semanas e viajou para a ilha de Helgoland, ao largo da costa da Alemanha. Ali, lembrou mais tarde, a natação no mar frio e longas caminhadas na praia limparam-lhe a mente para um ataque revigorado à matemática do átomo. Apenas alguns dias depois de iniciado o passeio, fez uma importante descoberta. Com uma estranha matemática que inventou para esse fim, Heisenberg começou a perceber um meio de construir uma estrutura para a descrição do comportamento dos átomos. Essa abordagem matemática exigia uma estranha álgebra em que números multiplicados numa direção forneciam com frequência produtos diferentes dos obtidos multiplicando-se os mesmos números na direção oposta. Heisenberg voltou para Göttingen eufórico com suas descobertas nascentes e ancioso para falar sobre elas com Max Born. Este identificou a estranha matemática de Heisenberg como álgebra matricial, um sistema que havia sido inventado na década de 1850 mas nunca fora ensinado a Heisenberg: na concepção de Heisenberg, cada átomo seria representado por uma matriz e o movimento dos elétrons no interior do átomo poderia ser representado por outra matriz (figura abaixo).

____________________________________________________________

____________________________________________________________

____________________________________________________________

____________________________________________________________

Prof. Tarcísio Haroldo Cavalcante Pequeno (UFC).

____________________________________________________________

____________________________________________________________

Bohr explicava a transição entre dois quaisquer estado energéticos do átomo por meio dum salto do elétron duma órbita representativa dum estado à outra. Associado a esses saltos quânticos, sempre aparecia um fóton que era radiado ou absorvido, de acordo com o sentido do salto eletrônico.

Novamente, Heisenberg se opunha a essa imagem transitória com seu mecanismo desconhecido. Ele reconhecia que, na observação experimental dos átomos, somente os níveis energéticos discretos “estacionários” podiam ser estabelecidos. Não determinamos experimentalmente os detalhes do que ocorre quando um elétron atômico muda dum estado a outro, como também não decidimos se o elétron descreve uma órbita no sentido clássico ou se comporta como uma onda estacionária ao redor do núcleo. Qualquer modelo explanatório que possamos construir só pode ter a finalidade duma melhor compreensão, representando apenas uma especulação. Contudo, é óbvio que, não sendo observadas certas circunstâncias, esses modelos podem mesmo levar à confusão. Por outro lado, uma certa regularidade na forma das transições entre os níveis energéticos discretos pode ser estabelecida experimentalmente, na qual o estado fundamental do átomo ocupa um papel prioritário.

____________________________________________________________

____________________________________________________________

Heisenberg e Bohr, 1935

____________________________________________________________

____________________________________________________________

Enfim, com respeito ao acabamento do desenvolvimento da mecânica das matrizes, podemos citar as próprias palavras de Max Born:

“O período de tentativas chegou subitamente ao fim, com o trabalho de Heisenberg, que era meu assistente naquele tempo. Ele cortou o nó górdio com um princípio filosófico novo e substituiu o raciocínio por uma regra matemática. Em essência, o princípio significava que noções e conceitos que não correspondessem a nenhum fato fisicamente observável não poderiam ser usados em qualquer descrição teórica”.

Assim, Werner Heisenberg aperfeiçoa o chamado cálculo matricial sobre bases estritamente probabilísticas, com a especial circunstância de que a matéria parece reduzir-se ao mero cálculo matemático. Donde pela primeira vez a imagem é varrida por completo da física. Com o cálculo de matrizes a matéria já não é partícula nem onda nem nenhuma outra coisa susceptível de descrição, mas aquilo que cumpre um puro esquema matemático regido pelos princípios da simetria.

Constata-se, então, que o conceito do átomo de Bohr é uma representação tridimensional grosseira de um átomo tetra dimensional que termina por não parecer em nada com a realidade; e, longe de ser uma ilustração didática, acaba sendo uma confusão de conceitos. Daí, Heisenberg, assim como seu companheiro Pauli, adota um número complexo de quatro termos (para cada dimensão) como único coisa necessária para tratar com o átomo.

Heisenberg havia apresentado seu próprio modelo de átomo renunciando a todo intento de descrever o átomo como um composto de partículas e ondas. Pensou que estava condenado ao fracasso qualquer tentativa de estabelecer analogias entre a estrutura atômica e a estrutura do mundo macroscópico. Preferiu descrever os níveis de energia e órbitas dos elétrons em termos numéricos puros, sem o menor traço de esquemas. Como usou um artifício matemático denominado “matriz” para manipular seus números, o sistema se denominou, como já foi dito aqui, “mecânica de matriz“.

Mas o ponto decisivo nesta construção era o dualismo corpúsculo-onda e a questão do influxo do “observador” sobre os processos físicos “reais” e “objetivos”. É sabido que o lugar e o impulso de uma partícula não podem ser simultaneamente, isto é, pela mesma experiência, medidos com exatidão. Quando se consegue medir exatamente uma das duas grandezas “complementares” (lugar e impulso, tempo e energia), a outra desaparece; no caso extremo da máxima exatidão na medição da primeira grandeza, a segunda não pode ser absolutamente medida. Tal é o conteúdo essencial das “relações de indeterminação” de Heisenberg.

Niels Bohr elaborou em 1927, depois de longas discussões, o conceito fundamental de complementaridade, que há pouco empregamos. Introduziu duas concepções inteiramente distintas para os processos quânticos, que são complementares no sentido que só podem existir lado a lado sem contradição quando seu alcance é limitado de tal modo que nunca são utilizadas ao mesmo tempo. Dependendo da experiência, a “partícula elementar” se mostra ora como corpúsculo, ora como onda.

____________________________________________________________

____________________________________________________________

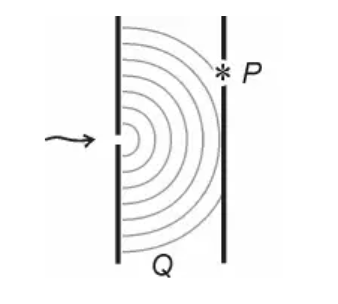

QUANTUM E O EXPERIMENTO DA DUPLA FENDA

______________________________________________________________________

Analisando o experimento da dupla fenda no vídeo acima, o Dr. Quantum adota um ponto de vista clássico, realista, na descrição do deslocamento do elétron ao longo de sua “trajetória” até encontrar a parede detrás, passando antes pelas fendas. Entretanto, a interpretação da mecânica quântica dada pela Escola de Copenhagen – a qual está fundada no anti-realismo (não realismo) dualista (onda-partícula), baseado na exclusão mútua constituída pelo Princípio da Complementaridade de Niels Bohr -, reprova todo este exercício de imaginação, ou seja, a “trajetória” ou a “localização” do elétron no tempo e no espaço não é um observável.

____________________________________________________________

____________________________________________________________

Entretanto, Heisenberg encara a questão de outro modo, o que é de particular importância para o nosso problema sobre o papel da matemática. Como vimos, acima, parte da hipótese que só se verificam na natureza, ou só podem ser processados experimentalmente, processos que se deixam representar como vetores (ou mistura de vetores)(observáveis) no espaço de Hilbert de muitas dimensões, numericamente infinitas. Modelo para Heisenberg era a teoria da relatividade restrita que igualmente representa a realidade física por vetores em meio ao “mundo” quadridimensional. Mas um vetor num espaço de Hilbert de dimensão infinita (ou na matriz hermitiana correspondente) não é intuitivo; não o é tão pouco a equivalente representação por uma onda no espaço de configuração segundo Schödinger; pois o espaço-configuração tem 3n dimensões para n partículas. Trata-se de uma simples analogia para uma onda intuitivamente tridimensional. A tentativa de uma interpretação intuitiva leva-nos novamente às duas imagens complementares (corpúsculo e onda) de Bohr.

Em meio a todas essas complexas tentativas de solução pergunta-se: o que dizer sobre a realidade física dos processos quânticos?

N. Bohr fala da “impossibilidade de uma distinção exata entre o comportamento de objetos atômicos e a influência sobre eles exercida pelos instrumentos medidores, que servem para determinar as condições em que os fenômenos se manifestam”.

Segundo Heisenberg, mesmo tendo em vista tal impossibilidade de distinção, pela intervenção de um observador não se introduz qualquer traço subjetivista na descrição da natureza, o que não deixa de ser muito importante do ponto de vista “filosófico”. Segundo ele, o observador tem simplesmente a função de registrar fatos que se verificaram no tempo e no espaço, pouco importando que o “observador” seja um aparelho que funciona automaticamente ou um ser vivo (de modo especial um homem que entende do assunto). O que entretanto é absolutamente necessário é a passagem do possível ao “factual” dentro do processo atual do registro. Este último ponto de Heisenberg se relaciona – o que ele mesmo nota – com a seguinte consideração de Weizsaecker: somente fatos futuros são ainda possíveis, os passados são simples fatos. Não tem sentido perguntar sobre a probabilidade (isto é, sobre a possibilidade quantitativamente determinável) de sua realização, pois já são reais. O que de fato já aconteceu não pode ser objeto de indagação quanto à possibilidade ou probabilidade de sua realização. Assim um fato histórico, como a do registro de um elétron pelo contador de Geiger, não entra numa teoria como a mecânica quântica que se ocupa de possibilidades (probabilidades).

Qualquer SISTEMA QUÂNTICO separado do mundo exterior só tem um caráter potencial, não factual; por isto, segundo Bohr, ele não pode ser descrito por conceitos da física clássica. O estado representado por um vetor de Hilbert (não por uma combinação estatística de vetores), aplicado a um sistema fechado, é, segundo Heisenberg, objetivo, mas não real, pois nele não se pode verificar um fato historicamente constatável em nosso mundo macroscópico (tais como a revelação de uma chapa fotográfica, a indicação de um instrumento, e semelhantes aparelhos de que nossas salas de física estão cheias). Portanto, a concepção clássica de objeto-real deve ser abandonada.

Assim, à luz da interpretação de Copenhague (ou, da ortodoxia da mecânica quântica), da teoria dos quanta, a oposição tradicioanal entre “realismo” e “idealismo” não pode mais ser empregada e as teoria tradicionais do conhecimento fracassam. Os processos que se verificam no tempo e no espaço de nosso ambiente diário são propriamente o real e deles é feita a realidade de nossa vida concreta. “Quando se tenta, diz Heisenberg, penetrar nos pormenores dos processos atômicos que se ocultam atrás desta realidade, os contornos do mundo “objetivo-real” se dissolvem, não nas névoas de uma nova imagem obscura da realidade mas na clareza diáfana de uma matemática, que conecta o possível (e não o “factual”) por meio de suas leis”.

………………………………………………………….

……………………………..

MECÂNICA QUÂNTICA

Matriz-S

Filosofia de Bootstrap – Universo Holográfico

Teoria das Cordas

………………………………………….

_______________________________________________________________

Atualmente, existem duas escolas de pensamento na física de altas energias (HEP) com pontos de vistas fortemente opostos com relação à constituição da matéria. A maioria dos físicos são “fundamentalistas”, aqueles que tentam reduzir a natureza a fundamentos, e procuram pelos “blocos básicos de construção” da matéria. Em oposição aos “fundamentalistas”, estão os “bootstrapers”, que procuram entender a natureza através da auto-consistência, e acreditam que toda a Física segue-se unicamente (ou seja, sem conter qualquer parâmetro arbitrário) da necessidade de que os seus componentes sejam consistentes uns com os outros e com eles próprios.

_________Geoffrey Chew_________

____________________________________

A teoria da matriz S foi uma proposta para substituir a teoria do campo quântico local como o princípio básico da física de partículas elementares.

Evitou a noção de espaço e tempo substituindo-a por propriedades matemáticas abstratas da matriz S. Na teoria da matriz S, a matriz S relaciona o passado infinito ao futuro infinito em uma etapa, sem ser decomponível em etapas intermediárias correspondentes a fatias de tempo.

Este programa foi muito influente na década de 1960, porque era um substituto plausível para a teoria quântica de campos , que era atormentada pelo fenômeno de interação zero em forte acoplamento.

Assim, no período do Pós-Guerra, a teoria da Matriz-S parecia formidável. Neste ínterim, ao redor da década de 1960, tornou-se uma teoria promissora. Em primeiro lugar, não precisava assumir a existência de partículas elementares (como, de fato, não assumia). Em segundo lugar, explicava a “força forte” . A teoria da Matriz-S oferecia “oportunidades” para os físicos teóricos de partículas. A teoria quântica de campos, por sua vez, malograva em fazer o mesmo.

A teoria da matriz S, entretanto, foi abandonada pelos físicos na década de 1970, quando a cromodinâmica quântica foi reconhecida por resolver os problemas de interações fortes dentro da estrutura da teoria de campos.

Hodiernamente, aplicado à interação forte, levou ao desenvolvimento da teoria das cordas. Ainda, sob o disfarce da teoria das cordas, a teoria da matriz S ainda é uma abordagem popular para o problema ada gravidade quântica.

A teoria da matriz S está relacionada com o princípio holográfico e a correspondência AdS/CFT por um limite de espaço plano. O análogo das relações da matriz S no espaço AdS é a teoria da conformação da fronteira.

____________________________________________________________

EMARANHADOS NO ESPAÇO–TEMPO

Hologramas Cósmicos

____________________________________________________________

O legado mais duradouro mesmo da teoria é a teoria das cordas. Outras realizações notáveis são o limite de Froissart , e a previsão do pomeron.

A partir de uma “Bootstrap Completa”, delineia-se uma verdadeira filosofia da natureza. A concepção de que a existência de um sistema hadrônico é dada pela sua auto-consistência leva a uma visão holística da natureza. Nas palavras do próprio Chew: “A hipótese da auto-consistência nos conduz a conceber que, para que um único hádron sequer possa existir, a família inteira de hádrons deve existir em uma estrutura de suporte mútuo”. Fritjof Capra – autor best-seller, discípulo e membro do grupo de pesquisa de Chew na década de 1970 – não foi nem o primeiro e nem o último a notar que o modelo de Bootstrap levava a uma “visão de mundo”. Devido ao Zeitgeist em que estava imerso, Capra o associou a filosofias orientais. O modelo de Bootstrap foi associado, no entanto, a diversas filosofias da natureza, a depender do especialista que refletiu sobre o modelo de Bootstrap.

Deve-se acrescentar que o modelo de Bootstrap leva a uma representação aparentemente paradoxal da Natureza. Ao não supor nem parâmetros empíricos arbitrários, nem entidades ou propriedades físicas não observáveis, o modelo não assume a existência de partículas elementares. No modelo de Bootstrap, ainda se fala em partículas, mas não mais as diferencia, entre compostas e elementares. (…) Isto devido ao fato de ser comprovado, através do modelo de Bootsstrap, que no nível quântico há uma coincidência entre a “parte” e o “todo”. Não apenas o “todo” contém a “parte”, mas a “parte” também contém o “todo”. Há uma coincidência dos opostos. Ademais, no modelo de Bootstrap, nenhuma partícula é mais fundamental, ou elementar, do que as demais partículas, o que Chew chamou de “democracia nuclear” (enquanto chamava de “fundamentalistas” os defensores da teoria quântica de campos).

Portanto, a filosofia da natureza resultante, que emergiria de uma teoria de Bootstrap Completa, capaz de abranger todas as partículas e suas interações, assemelha-se a um universo holográfico. Sabe-se que o holograma possui uma característica única, a saber, cada uma de suas partes contém a informação do todo. Esta Naturphilosophie holográfica seria explorada e apropriada pela ciência “New Age” a partir da década de 1980 (o chamado “paradigma holográfico”). Neste sentido, a Filosofia de Bootstrap, nascida na década de 1960, seria considerada pioneira do “paradigma holográfico”.

O trabalho de David Bohm de 1952 é um exemplo nas ciências físicas de um “paradigma holográfico” (através de sua interpretação determinista da mecânica quântica de 1952 e a de sua teoria do holomovimento apresentada em seu livro “A Totalidade e a Ordem Implicada” de 1980). Bohm reformulou uma interpretação determinista da mecânica quântica em 1952 muito próxima daquela formulada pelo físico francês Louis de Broglie em 1927.

A Filosofia de Bootstrap, por sua vez, se harmonizava com os princípios ecológicos, se insurgia contra o atomismo-mecanicista das ciências ocidentais, se rebelava contra o establishment científico, e espelhava a mensagem das filosofias orientais; como refletiria Capra depois sobre o seu ensaio de 1974: “Nesse ensaio, argumento que o contraste entre os ‘fundamentalistas’ e os ‘bootstrappers’ na física das partículas reflete o contraste entre duas correntes prevalecentes no pensamento do Ocidente e do Oriente”.

…………………………………………………

………………………………………….

LÓGICA E ONTOLOGIA

Teorema de Bell

…………………………………………..

…………………………………………………….

JOHN BELL

____________________________________________________________

____________________________________________________________

O físico John Bell toma um caminho que parece se coadunar com o de Heisenberg. Para Bell, não se trata apenas de um problema de linguagem, trata-se de uma questão de Lógica e de Ontologia, ou seja, o problema está em pensar o “universo” e “espaço-tempo” como dois conceitos relacionados pela lei de identidade A=A. Se esta relação fosse o caso, e se o elétron não se encontra no espaço-tempo, logo não se encontra no universo, e como o universo é tudo que existe, logo o elétron não existe durante o “salto quântico“. Como universo é tudo que existe, ao identificar “universo” com “espaço-tempo”, chegamos ao absurdo de formularmos, ou que alguma coisa existe fora daquilo que contêm todas as coisas, ou que algo desaparece da existência, e a ela retorna, vindo de lugar algum e indo para um nada absoluto. Bell elaborou um teorema para elucidar a questão, segundo o qual, os sinais não-locais e os saltos quânticos só são paradoxais se aceitarmos que a única realidade possível é o espaço-tempo descrito pela teoria relativística, contudo, se introduzirmos uma Realidade não-local, o paradoxo desmorona. Isto equivale a alargar nosso conceito de “universo”, não aceitando a identidade A=A entre “universo” e “espaço-tempo”. Penso que é o caso de dizermos que “Todo o espaço-tempo (S) é Universo (P)”. Dizermos que todo S é P, é inserirmos S no universo de P, ou seja, é tomarmos S como elemento do conjunto P. “Todo S é P”, neste sentido, implica que “Algum P é S”. Alguma parte do universo é espaço-tempo, ou, o espaço-tempo corresponde a alguma quantidade dos elementos do conjunto “universo”, mas não a totalidade de elementos. Durante o salto quântico, os elétrons (X) não existem em S, mas permanecem como entes, ou elementos, de P. Segundo Bell, as partículas correlacionadas estão ligadas por elos não-locais, ou seja, estão vinculadas para além do espaço-tempo, é por isso que interações quânticas instantâneas são possíveis, e que os saltos quânticos ocorrem. Um enunciado “belliano” para o salto quântico seria: “Durante o salto quântico o elétron existe (X é P) em outro nível de realidade que transcende os limites físicos do espaço-tempo (S)”.

Sete décadas, portanto, após o nascimento da mecânica quântica, a natureza desta novidade da causalidade foi esclarecida pelo teorema teórico rigoroso de Bell e por experimentos de grande precisão. Um novo conceito assim se introduziu na física: a não-separabilidade.

As entidades quânticas continuam a interagir independentemente da sua distância. Aparentemente, surge um novo tipo de causalidade – uma causalidade global que diz respeito ao sistema de todas as entidades físicas, como um todo.

____________________________________________________________

____________________________________________________________

Donde as entidades quânticas – os quanta – são corpúsculos e ondas ou, mais precisamente, não são nem partículas nem ondas.

Daí as célebres relações de Heisenberg mostrarem, sem qualquer ambiguidade, que é impossível localizar um quantum em um ponto preciso do espaço e em um ponto preciso do tempo. Em outras palavras, é impossível atribuir uma trajetória bem definida a uma partícula quântica. Mas tal indeterminismo que prevalece na escala quântica é um indeterminismo constitutivo fundamental e irredutível que não significa acaso ou imprecisão: “uma matemática, que conecta o possível (e não o “factual”) por meio de suas leis”.

…………………………………………..

…………………………………………..

…………………………………………………….

MEDIDA

Ôntica e Ontológica

………………………………………….

…………………………………………………….

____________________________________________________________

____________________________________________________________

HÁ DOIS MODOS DIFERENTES de medir, ressaltava o filósofo grego Platão. Um envolve números, unidades, uma escala e um ponto de partida. Estabelece que uma propriedade é maior ou menor que outra, ou atribui um número a quanto de uma dada propriedade algo possui. Podemos chamá-lo de medição “ôntica”, empregando o termo aplicado por filósofos a objetos ou propriedades reais de existência independente. A mensuração ôntica evoluiu a partir de improvisadas medidas corporais e artefatos desconexos até chegar a uma rede universal que relaciona muitos tipos diferentes de medição e, em última instância, os vincula a padrões absolutos – constantes físicas.

Todavia, existe outro modo de medir que não envolve colocar-se ao lado de um bastão graduado ou de um prato de balança. Esse é o tipo de medição que Platão dizia ser guiado por um padrão “apropriado” ou “correto”. Essa forma de medir é menos um ato do que uma experiência; a experiência de que as coisas que fizemos são – ou nós mesmos somos – menos do que poderiam ou deveriam ser. Não podemos efetuar esse tipo de medição seguindo regras, e ela não se presta a quantificação. Será apenas uma medição “metafórica”. Ela é uma comparação relativa a um padrão. Colocadas junto a exemplo apropriado ou correto, as nossas ações – e até nós mesmos – não são suficientes; é possível ser mais. Sentimos que não estamos à altura do nosso potencial. Podemos chamar essa medição de “ontológica”, conforme o termo que os filósofos usam para descrever a maneira como algo existe.

A medição ontológica não envolve uma propriedade específica, em sentido literal, pois não envolve nada quantitativo. Podemos calcular tudo que nos aprouver; jamais produziremos esse tipo de medição. Não há nenhum método que nos leve a ela. A medição ontológica nos liga a algo transumano, algo de que participamos, não algo que comandamos. Enquanto na medição ôntica comparamos um objeto a outro exterior a ele, na medição ontológica nós nos comparamos, ou alguma coisa que tenhamos feito, com algo no qual nosso ser está implicado, com o qual está relacionado – tal como um conceito de bom, justo ou belo. A medição ontológica é onticamente imensurável.

Como facilmente constatamos, ao ôntico corresponde o ponto de vista objetivo e, ao ontológico, o ponto de vista subjetivo:

“Geralmente estamos convencidos de que entre as várias experiências, tanto pessoais como impessoais, existem algumas que compartilhamos com nossos colegas. Quando minha esposa tem uma dor de dentes, então isso é uma experiência ‘subjetiva’ dela. Não obstante eu possa imaginar sua dor e mesmo mostrar minha simpatia, não sinto essa dor. Mas se ela diz: ‘Veja como o céu está azul hoje’ e eu concordo, então fico convencido de que vemos o mesmo ‘azul’; esta é uma experiência ‘objetiva’, compartilhada com qualquer um que esteja olhando o céu. Apesar disso, não há realmente nenhuma diferença: você vê o ‘seu azul’, eu vejo o ‘meu azul’ e não há um meio de conseguir que eu veja o seu azul e você veja o meu. Como nos convencemos de que estamos vendo a mesma coisa?

Em primeiro lugar, somos feitos como todos os outros animais. O inseto, que voa em direção a uma flor, é atraído pela cor, pelo perfume e pela forma, da mesma maneira como todos os outros insetos. A mesma coisa ocorre aos seres humanos na vida quotidiana. Uma observação que impressione um de nossos sentidos, tal como a vista do azul do céu, é um caso relativamente raro; em geral, mais de um dos sentidos são impressionados de forma que, a observação das coisas que são perceptíveis aos diferentes sentidos, nos chega sem nenhum esforço consciente.

Mas, há um outro ponto importante: não obstante uma simples impressão sensorial seja completamente subjetiva e não comunicável, o mesmo não se dá quando temos duas impressões no mesmo órgão sensitivo.

Existem muitas tonalidades do azul; por exemplo, pálido, escuro, avermelhado e esverdeado. Se duas dessas tonalidades são observadas por duas pessoas, é quase certo que haverá acordo entre elas sobre se as tonalidades são as mesmas ou distintas. Assim, podemos classificar as impressões sensoriais como pertencentes à classe das experiências objetivas, desde que consideradas aos pares. Sobre este claro reconhecimento da similaridade ou não de pares de impressões sensoriais é que estão baseados todos os meios de comunicação entre as pessoas, em particular nossas linguagens escritas e faladas.

Tomemos, por exemplo, pares de letras: que AA são similares e que AB não o são, eu posso concordar com qualquer um, mesmo com alguém que não saiba como A e B são pronunciados. Assim, letras são ‘objetivas’ no sentido de que são facilmente transmissíveis. A matemática é a forma mais altamente desenvolvida de comunicação por meio de sinais que intrinsecamente não teriam sentido.

O conhecimento científico, em especial a Física, também se enveredou pelo caminho que leva ao desenvolvimento de pares de impressões sensoriais, ao invés de impressões isoladas: se o indicador de um instrumento de medida sofre uma deflexão até certo ponto da escala de medida, isso indica não só uma porção de escala que foi percorrida, mas também o valor de uma propriedade física, por exemplo, a intensidade da luz. Ou seja, a Física busca sempre a objetividade no tratar com os seus objetos de estudo.” (BORN, 1972).

…………………………………………..

…………………………………………………….

PROBLEMA DE MEDIÇÃO

A Física Moderna

Vira Matemática

………..

…………………………………………..

…………………………………………..

A Física Moderna transformo-se em matemática. Mas as pessoas preferem impressões visuais a palavras abstratas e fórmulas. Jornais, revistas ilustradas, filmes, televisão, internet, tudo contribui para reforçar essa preferência. A principal dificuldade em apresentar as ideias físicas através de figuras claras e lúcidas ou ilustrações, é que nem sempre a Física admite figuras bem definidas; pelo contrário, frequentemente usa uma variedade de figuras diferentes para a representação e interpretação de um mesmo processo. Exemplo clássico disto é o elétron para cuja representação se pode utilizar uma “onda” ou uma “partícula”.

Acima, verificamos dois fatos históricos que são fundamentais à critica do filme “Quem Somos Nós?”. O primeiro se deu ainda na Antiguidade quando Parmêncides e Heráclito discutiam sobre o MOVIMENTO. O segundo ocorreu quando da criação da MECÂNICA QUÂNTICA. Ambos os fatos históricos se relacionam com o problema da MEDIDA na matemática e na física.

Quando, então, da medida ôntica da hipotenusa no Triângulo Retângulo Isósceles, o Mundo Grego Antigo desabou: isto se deu por causa da descoberta dos INCOMENSURÁVEIS e a consequente constatação do infinito nas medidas.

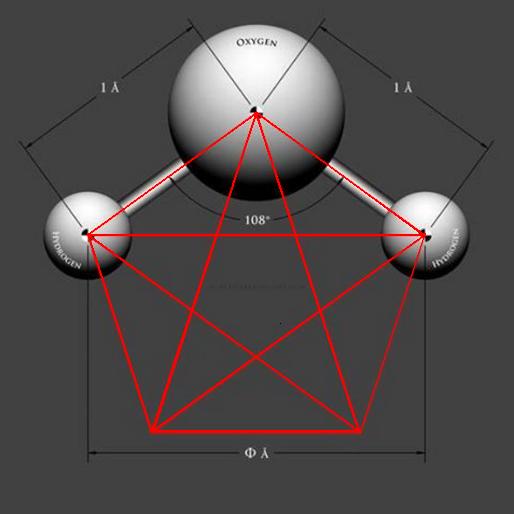

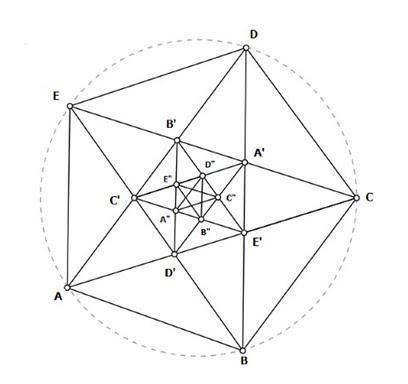

Abaixo, na figura, temos o pentagrama – símbolo dos pitagóricos -, através do qual se demonstra a aparição do infinito nas medidas.

____________________________________________________________

____________________________________________________________

Constatação do Infinito nas Medidas e a Descoberta dos Incomensuráveis

________________________________________

Traçando as diagonais (ver figura acima) de um pentágono regular obtemos um pentagrama; no interior deste podemos construir outro pentágono, o qual, traçando também suas diagonais, obtemos mais um pentagrama, e assim sucessivamente de modo que a figura é sem fim em seu interior. Mas podemos medir um lado do pentágono, seja de DE, pela diagonal AC simetricamente oposta; neste caso o quadrilátero ED’CD é um paralelogramo e, portanto, CD’ = DE. Daí, o lado DE ou CD’ está contido uma vez na diagonal CA, ficando o resto AD’. Quando se mede AD’ em AE’ (que é igual ao lado DE da mesma forma) está aí contida uma vez deixando o resto E’D’. Ora, E’D’ é o lado do pentágono interno A’B’C’D’E’ e a diagonal deste C’A’ é igual a D’A (pois AD’A’C” é um paralelogramo. Depois a mesma relação se repete e o processo da “diminuição recíproca” continua sem fim, INFINITO!

Foi este interessante resultado que chamou a atenção de Zenão que pôs fim ao domínio da Escola de Pitágoras. Hodiernamente, a menor distância alcançada ou concebível na prática em experiências da física atômica é o COMPRIMENTO DE PLANCK: cerca de 1 para 1020 do diâmetro de um próton!

____________________________________________________________

____________________________________________________________

Contribuindo para a solução dos problemas científico-filosóficos advindos com a descoberta dos incomensuráveis, Parmênedes, na Antiguidade Grega, foi o primeiro pensador a contribuir para o início da epistemologia ao distinguir aquilo que era objeto puramente da razão (o que chamou de verdade) e o que era dado pela observação, pelos sentidos (o que denominou de opinião). Opondo, então, a razão à opinião, o Eleata estabeleceu um critério segundo o qual somente o conhecimento dado pela razão tinha valor científico-filosófico.

Foi exatamente um discípulo de Parmênides, Zenão de Eléia, sabendo da problemática dos pitagóricos na modelagem do movimento e usando o conceito de razão (verdade) de seu mestre, passa a destruir todo o edifício construído pelos discípulos de Pitágoras. Assim, matematicamente, o movimento não podia mais ser explicado, pois, o conhecimento dado pela verdade, pela razão, o contradizia. Logo, por dedução, concluiu-se que todo movimento não passava de pura ilusão.

_____________________________________________________________

_____________________________________________________________

_______________________________________

Mito da Caverna

_______________________________________

Platão descreve que alguns homens, desde a infância, se encontram aprisionados em uma caverna. Nesse lugar, não conseguem se mover em virtude das correntes que os mantém imobilizados.

Virados de costas para a entrada da caverna, veem apenas o seu fundo. Atrás deles há uma parede pequena, onde uma fogueira permanece acesa.

Por ali passam homens transportando coisas, mas como a parede oculta o corpo dos homens, apenas as coisas que transportam são projetadas em sombras e vistas pelos prisioneiros.

Nosso Mundo Material, portanto, corresponderia às sombras e o Mundo das Ideias corresponderia às coisas-em-si, as quais são transportadas por trás da parede. Ou seja, para Platão o conhecimento sensível (opinião) da realidade é a visão dos homens da caverna e o conhecimento intelectual (razão), através do qual se alcança a essência das coisas, é a visão fora da caverna.

_____________________________________________________________

_____________________________________________________________

Confirmando o pensamento eleata, Platão – através da Segunda Navegação -, complementa tal pensamento através de sua famosa CAVERNA (figura acima): postulou, então, a existência do Mundo das Ideias, no qual residiria a verdadeira realidade, e, o Mundo em que vivemos, apenas projeção da sombra de tal mundo ideal. Como vemos, toda essa reviravolta na visão que o homem antigo tinha do Universo foi causada pela simples descoberta do INFINITO nas medidas, ou seja, os incomensuráveis. Assim, a matemática grega incapacitada de lidar com tais medições, favoreceu a ruína da Visão de Mundo dos pitagóricos a qual era vigente nesta época. Daí, por diante, Platão, tentando por ordem na “casa”, fez nascer o mundo das Ideias, com base nas quais passou a geometrizar toda a matemática de sua época: ou seja, desde que uma teoria sobre a natureza de caráter puramente aritmético era impossível, o modelo geométrico se constituiu como um novo método matemático para a descrição do mundo.

No vídeo, abaixo, temos uma pequena discussão sobre o Cálculo Infinitesimal e sobre o fato que desencadeou o seu desenvolvimento: a constatação do infinito nas medidas de segmentos de reta dadas no pentagrama.

____________________________________________________________

____________________________________________________________

____________________________________________________________

____________________________________________________________

A partir de uma simples medida da hipotenusa de um triângulo, portanto, se gerou toda uma controvérsia entre IDEALISTA e REALISTAS, entre espiritualistas e materialistas, entre teoria e prática, que se estendeu até os dias de hoje.

Mas, com a continuação das pesquisas na matemática e na física, finalmente foi possível racionalizar ou matematizar o movimento, ou seja, transformá-lo num objeto puramente da razão, como definido por Parmenênides. Esta possibilidade foi concretizada, então, com a criação do Cálculo Infinitesimal. Portanto, principalmente com Newton e Leibniz – criadores do Cálculo Diferencial e Integral -, temos a superação de tal controvérsia envolvendo o MOVIMENTO, proporcionando assim que o PITAGORISMO (Aritmética) fosse definitivamente adotado pela ciência na modelagem matemática da Natureza.

“É tortuosa, no entanto, ainda hoje, a história das noções sobre o MOVIMENTO. Zenão o achava paradoxal e ininteligível. Galileu e Newton o consideravam óbvio e trivial e, finalmente, Einstein corrigiu um equívoco fundamental na análise do óbvio. Para azarar ainda mais, hoje se sabe que as noções atuais sobre o movimento, relativo ou não, não podem ser estendidas para deslocamentos arbitrariamente pequenos. A mecânica quântica, considerada conjuntamente com a relatividade geral, nos leva a concluir que a visão atual do espaço e do tempo não se aplica a distâncias tão pequenas quanto 10 elevado a potência de -35 metros e intervalos de tempo tão pequenos quanto 10 elevado a potência de -43 segundos, e, sem entender espaço e tempo, não há como entender o movimento. Nesta escala (chamada de PLANCK), as dificuldades apresentadas por Zenão para a descrição do movimento da ponta de uma flecha se transformam em um problema real. Zenão, o CONFUSO, atirou no cachorro e acertou na codorna!”. (CHAVES).

Hoje, novamente, por conta de uma problemática gerada pelas medidas da posição e do momento do elétron em dado experimento físico, temos uma nova reviravolta com relação a Visão de Mundo consagrada pela comunidade científica atual e fundamentada na Física Clássica. Ou seja, a realidade ao nível atômico é segundo um novo paradigma dado pela Mecânica Quântica: na “interpretação de Copenhague”, mesmo a oposição tradicional entre idealismo e realismo não pode mais ser empregada e as teorias tradicionais do conhecimento fracassam.

Ao nível dos quanta, portanto, no processo de medida, dar-se a problemática do observador (que mede) e do observado (o objeto medido): ou melhor, a dicotomia espírito/matéria, alma/corpo, observador/observado, iniciada com Platão e sacramentada por Descartes, está fadada ao fracasso.

Ante tal problemática, Heisenberg, esclarece que qualquer modelo explanatório construído para representar a realidade só pode ter a finalidade duma melhor compreensão, representando apenas uma especulação. Os processos que se verificam no tempo e no espaço de nosso ambiente diário são propriamente o real e deles é feita a realidade de nossa vida concreta. Agora, diz Heisenberg, “quando se tenta penetrar nos pormenores dos processos atômicos que se ocultam atrás desta realidade, os contornos do mundo objeto – real se dissolvem não nas névoas de uma nova imagem obscura da realidade, mas na clareza diáfana de uma matemática que conecta o possível (e não o ‘factual’) por meio de suas leis”. Daí, a Física Moderna transformou-se em matemática.

Na concepção de Heisenberg, aperfeiçoado o seu cálculo matricial sobre bases estritamente probabilísticas, cada átomo seria representado por uma matriz e o movimento dos elétrons no interior do átomo poderia ser representado por outra matriz. Assim, a especial circunstância de que a matéria parece reduzir-se ao mero cálculo matemático, estabeleceu que, pela primeira vez na História da Ciência, a imagem fosse varrida por completo da Física. Com o cálculo de matrizes a matéria já não é partícula nem onda nem nenhuma outra coisa susceptível de descrição, mas aquilo que cumpre um puro esquema matemático regido pelos princípios de simetria. Em outras palavras, a Física Moderna desmaterializou a matéria: não conhecemos os objetos, mas suas relações, suas estruturas, assim, ignoramos o que seja a realidade em si e só tomamos contato com os fenômenos, a partir dos quais construímos os conceitos.

Mais acima, nas palavras de Fritz Kahn, podemos constatar o posicionamento da Nova Física: o que podemos saber sobre a realidade, se resume àquilo que é possível representar através dos conceitos matemáticos.

………………………………………….

…………………………………………………….

COLAPSO DA ONDA QUÂNTICA

Como é que o Cientista Mede um Objeto Quântico

………..

…………………………………………..

…………………………………………..

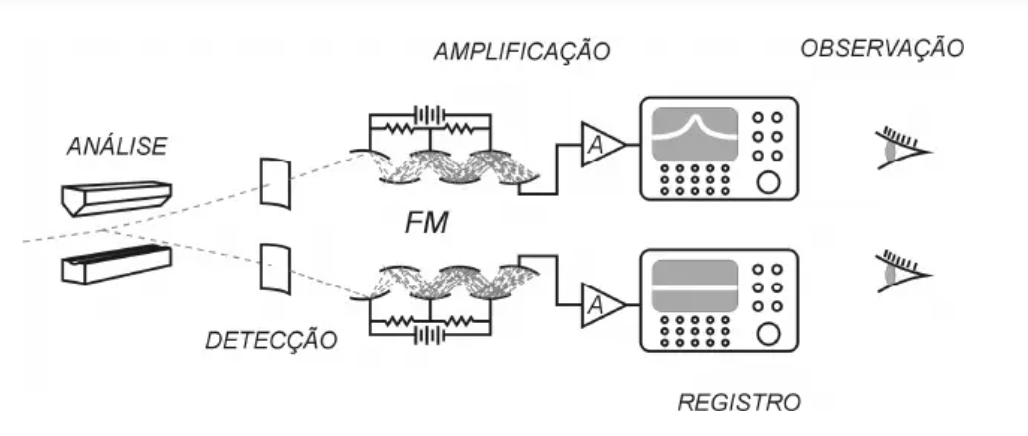

Na verdade, a medição de um objeto quântico costuma envolver uma intrincada aparelhagem experimental. Entre o objeto e a consciência do cientista, há uma cadeia de diferentes etapas, representada esquematicamente na figura abaixo.

____________________________________________________________

____________________________________________________________

A “análise” refere-se à separação do feixe em diferentes componentes. Na figura, representa-se o experimento de Stern-Gerlach. O termo “detecção” refere-se ao instante em que o objeto quântico encosta na fina placa metálica do detector, e interage com o “mar de elétrons” presente no metal.

Notem que há duas linhas pontilhadas, cada uma caindo em uma placa detectora. Essas duas linhas representam um único átomo, que está superposto nos dois caminhos. Cada um desses componentes interage com elétrons no metal, e isso pode acabar fazendo um elétron sair voando do outro lado da placa. Mas notem que isso acontece nas duas placas. Portanto, há agora uma superposição de elétron, cada componente rumando por um caminho, mas ambos associados a um único elétron.

A etapa seguinte é extremamente importante: é a amplificação. Nesta etapa ocorre um aumento de energia (fornecida por uma bateria), necessário para que o ser humano possa ver o resultado da medição. O instrumento representado na figura chama-se “fotomultiplicador”(FM), e era muito usado há meio século atrás. Ele contém uma série de placas: quando um elétron cai em uma placa, três elétrons são ejetados. Esses três são acelerados e caem em outra placa, gerando nove elétrons. Esse processo continua ao longo de doze placas, e no final tem-se um milhão de elétrons!

Será que esses milhões de elétrons continuam em um estado de superposição? Esta é a pergunta crucial para a física moderna, mas ninguém conseguiu realizar um experimento que fornecesse uma resposta. Há, é claro, diferentes teorias a respeito, mas não há nenhuma comprovação experimental!

As visões mais próximas do misticismo quântico, assim como a interpretação dos muitos mundos, supõem que a superposição continua após a amplificação. Há, em seguida, uma outra etapa de amplificação eletrônica (A), e finalmente um registro macroscópico definitivo da informação a respeito do caminho no qual o objeto quântico foi detectado. Tal registro também poderia estar numa superposição, segundo as visões mencionadas.

Finalmente, chega-se à última etapa da cadeia da medição, que é quando o ser humano observa conscientemente os sinais registrados no papel ou em uma tela de computador. Neste instante, com certeza, o cientista observa apenas um sinal, e não dois em superposição. Daí, quando da observação, passamos do tratamento indeterminista, estatísitico, da mecânica quântica, para o tratamento determinista, não-estatístivo, da mecânica clássica. Donde o observador então pode anunciar: “ocorreu um colapso da onda quântica ou da função de onda”!

Mas uma dúvida permanece! Se o colapso for algo real, onde e quando ele ocorre? Na detecção? Na amplificação? No registro macroscópico? Ou na observação feita por um ser consciente?

…………………………………………………

………………………………………….

REALISMO E POSITIVISMO

Anti-Realismo da Mecânica Quântica

…………………………………………..

…………………………………………………….

________________________________________

Aqui, postamos texto, na íntegra, de Oswaldo Pessoa Jr., retirado de seu livro Conceitos de FÍSICA QUÂNTICA. Tomamos a liberdade de fazer alguns grifos e apresentar o texto com algumas modificações sem importância

________________________________________

1. Realismo em Geral

Você é um realista? Distingamos primeiramente um sentido “ontológico” (relativo às essências das coisas, ao “ser” das coisas) e um sentido “epistemológico” (relativo ao conhecimento). O realismo ontológico é a tese de que existe uma realidade lá fora que é independente de nossa mente (ou de qualquer mente), de nossa observação. A negação desta tese é chamada de idealismo, que pode assumir várias formas, conforme veremos. O realismo epistemológico afirma que é possível conhecer esta realidade, ou seja, que nossa teoria científica também se aplica para a realidade não observada. Exploraremos inicialmente essas teses no nível do conhecimento individual, para depois analisarmos a forma que o realismo epistemológico assume quando consideramos o conhecimento científico – o chamado de realismo científico.

Para começar, devemos salientar que o termo “realismo” tem mudado de significado ao longo da história. Na filosofia medieval, o realismo era a tese de que os universais (“a árvore”, “a cadeira”, “o homem”) existem antes das coisas particulares, tese esta que estava associada à filosofia de Platão. A esta posição se opunha o nominalismo, segundo o qual os universais são meros nomes, e a realidade só se refere ao particular do mundo físico atual (Guilherme de Occam, século XIV).

No século XIX o termo “realismo” surgiu principalmente nas artes como reação ao romantismo. Este último apresentava uma atitude holística, orgânica, intuitiva, idealizadora, que em ciência influenciou a Naturphilosophie (início do século: Goethe, Schelling, Oersted). A reação realista nas artes realçava o cotidiano e o social, tendendo a ser politicamente mais progressista.

Na ciência, o realismo estava associado ao mecanicismo e ao atomismo, com uma valorização da quantificação e do método hipotético-dedutivo. Ele se contrapunha ao positivismo, originado com A. Comte e defendido por E. Mach e energeticistas como W. Ostwald. Para o positivismo, qualquer especulação sobre mecanismos ocultos deve ser evitado. Só tem sentido tecer afirmações sobre o que é observável, verificável. Uma sentença “sem sentido” é aquela para a qual não há um método para verificar se ela é verdadeira ou falsa. Por exemplo, a frase “a realidade física existiria mesmo que não existisse nenhum observador” seria sem sentido. Para o realista, porém, tal frase não só tem sentido como é verdadeira.

No século XX, a questão de como fundamentar o uso da matemática na ciência levou ao “positivismo lógico” (Viena: M. Schlick, R. Carnap) e “empirismo lógico” (Berlim: H. Reichenbach). Formas abrandadas dessas correntes tiveram bastante força até o início da década de 1960, na filosofia da ciência. Na década de 50, iniciou-se uma reação contra o positivismo lógico, centrando-se fogo especialmente no seu “empirismo”, tese de que as observações são bases seguras para construir a ciência (K. Popper, W. Quine). Por um lado, autores “relativistas” (M. Polanyi, N. R. Hanson, P. Feyerabend, T. Kuhn) atacaram a ênfase excessiva na descrição lógica da ciência, salientando que o conhecimento tem um componente intuitivo, e que ele está sujeito às circunstâncias históricas e sociais. De outro lado, a corrente do “realismo científico” (G. Maxwell, H. Putnam) foi elaborada, e tentaremos esboçá-la adiante.

Em outros campos, fora da filosofia da ciência, o “positivismo” foi também bastante atacado, tendo-se tornado até um termo depreciativo. Este sentido negativo parece ter surgido com as teorias positivistas em Ciências Humanas (inclusive na Educação), como o “behaviorismo” em Psicologia, que simplifica ao máximo a representação que se tem do ser humano, focalizando seu estudo apenas na relação entre estímulo e resposta (os dados “positivos”). Tal abordagem pode ser usada para se justificar a manipulação e dominação de homens por outros homens, tendo sido bastante criticada, como por exemplo pela Escola de Frankfurt (T. Adorno, J. Habermas, etc). Salientemos então o seguinte: no presente estudo, iremos nos concentrar na discussão entre formas de realismo e anti-realismo nas Ciências Naturais, onde “positivismo” não é necessariamente um termo depreciativo.

2. Os Problemas do Conhecimento

Um ponto crucial para entender as diferentes formas do anti-realismo, ou o que significam os diferentes “ismos” filosóficos, é considerar o tipo de pergunta que cada um responde. Adaptaremos aqui as análises feitas pelo filósofo alemão Johannes Hessen e pelo filosófo da ciência finlandês Ilkka Niiniluoto.

Consideremos primeiramente o problema ontológico da existência de uma realidade independente do sujeito ou de uma mente. Já mencionamos que o realismo ontológico afirma a existência desta realidade; a negação desta tese recairia em um “idealismo ontológico”, que é mais conhecido como idealismo subjetivista. A forma mais radical desta é o “solipsismo”, segundo o qual a realidade se resume ao conteúdo do meu pensamento: a realidade seria uma espécie de sonho em minha mente. Uma forma menos radical é a doutrina do “esse est percipi” (Berkeley, séc. XVIII), segundo a qual só existe aquilo que é percebido por alguém. Berkeley termina por defender um idealismo objetivo, porque a realidade externa existiria enquanto atividade mental de Deus. Tal idealismo é consistente com o realismo ontológico. Vemos assim que o idealismo não surge apenas como negação do realismo ontológico. Um idealismo epistemológico (que negaria o realismo epistemológico) defenderia a impossibilidade de se conhecer entidades independentes de qualquer sujeito cognoscente.

Podemos aceitar a existência de uma realidade exterior e colocar o problema epistemológico que Hessen chama de problema da “essencia do conhecimento”: é o objeto que determina o sujeito (realismo), ou é o sujeito que determina o objeto do conhecimento (idealismo)? O idealismo transcendental daquele que é considerado o mais importante filósofo moderno, o alemão Immanuel Kant (séc. XVIII), adota uma posição intermediária: aceitar a existência de coisas-em-si (“noumeno”), mas considera que a existência só acessa às coisas-para-nós, os “fenômenos”. Tais fenômenos, porém, seriam organizados pelo nosso aparelho perceptivo e cognitivo, sendo assim em parte dependentes do sujeito (isso também é defendido pelo idealismo conceitual de N. Rescher, 1973). A causalidade, por exemplo, não existiria na realidade, mas seria uma “categoria do entendimento”, uma estrutura cognitiva sem a qual a própria compreensão do mundo seria impossível.

No outro extremo, um tipo importante de realismo é o materialismo, para o qual apenas a matéria (e energia) existe ou é real: processos mentais seriam “epifenômenos” causados por processos materiais. O marxismo, uma forma de materialismo, considera que as ações humanas são determinadas pelos aspectos econômicos.

Consideremos agora um outro problema epistemológico, que é o da “possibilidade do conhecimento”: pode o sujeito apreender o objeto, pode ele conhecer verdades a respeito do mundo? Diferentes formas de realismo afirmam que sim, enquanto que a negação desta tese se chama ceticismo. Dentre as atitudes intermediárias podemos mencionar o pragmatismo (séc. XIX: C. S. Peirce, W. James), que leva em conta apenas as conseqüências práticas das idéias, e que é uma forma de relativismo. O relativismo considera que nosso conhecimento e as verdades dependem do contexto psicológico e social no qual nos encontramos.

Por fim, consideremos o problema da “origem do conhecimento”: é a razão ou é a experiência a fonte e a base do conhecimento humano? O empirismo considera que a única fonte de conhecimento é a experiência. Conhecimento sobre o que existe não pode ser obtido de maneira “a priori”. Os significados das idéias seriam redutíveis aos dados da experiência (séc. XVII-XVIII: F. Bacon, J. Locke, D. Hume). O sensacionismo (em inglês: “sensationalism”) ou “empirismo radical” enfatiza que as idéias são redutíveis às sensações (sense data), e no final do séc. XIX esta posição foi defendida pelo “empirio-criticismo” de Ernst Mach. A posição de Mach também é considerada uma forma de idealismo subjetivista, devido à tese de que “o mundo consiste apenas de sensações”. Uma forma mais pragmática de empirismo é o fisicalismo, para o qual os termos descritivos da linguagem se referem a objetos físicos (não sensações) e suas propriedades, e são definidos “operacionalmente”. Para o operacionismo (década de 1920: P. Bridgman), todo conceito científico é sinônimo do conjunto de operações físicas associados ao processo de medi-lo.

O ponto de vista oposto ao empirismo é o racionalismo (ou melhor, intelectualismo), que defende que o critério de verdade não é sensorial mas intelectual e dedutivo (R. Descartes, séc. XVII). Verdades básicas são evidentes para a razão, e outras verdades são dedutíveis destas. A posição de Kant pode ser considerada intermediária entre o empirismo e o racionalismo.

Para finalizar, salientemos que o positivismo não envolve uma tese única, mas consiste de quatro afirmações principais [98 a]: (i) Descritivismo: só faz sentido atribuir realidade ao que for possível descrever, observar. (ii) Demarcação: teses científicas são claramente distinguidas de teses metafísicas e religiosas, por se basearem em “dados positivos” (são verificáveis). (iii) Neutralidade: o conhecimento científico deve ser separado de questões de aplicação de valores. (iv) Unidade da ciência: todas as ciências têm um método único, baseado no empirismo e na indução.