Arquivo mensal: abril 2007

O HOMEM PERDIDO DENTRO DA NATUREZA

O texto, abaixo, de A. da Silva Mello, foi extraído de seu livro ILUSÕES DA PSICANÁLISE… postado, aqui, sim, mais como uma reflexão, a qual conduz, certamente, a uma visão mais nítida da condição humana (os grifos são nossos e, também, a indicação dos sites).

O que se tem tornado evidente é que o homem se encontra perdido dentro do mundo, não havendo nele encontrado o seu verdadeiro lugar, sobretudo devido à sua maneira de pensar. Em vez de tomar a vida como ela é, pondo a moral, a justiça, a estética de acordo com a Biologia, temos criado padrões falsos e arbitrários, que muito têm prejudicado a nossa felicidade, não raro tornando-nos bárbaros e arrogantes, mesmo em relação ao trato que damos aos nossos semelhantes e aos próprios animais. Não é por outra razão que precisamos rever esses valores, pondo os nossos instintos de acordo com a natureza, no sentido de a satisfação, a alegria, a felicidade, tornarem-se parte integrante tanto da nossa vida, quanto da nossa moral. Mas, em vez de seguir esse caminho, a nossa existência tem-se tornado cada vez mais artificial e sofisticada, acarretando toda sorte de malefícios ao nosso corpo e à nossa alma. Em vez de a cultura e a civilização haverem favorecido o desenvolvimento das nossas qualidades afetivas e emocionais, têm antes contribuído para recalcar e desvirtuar os nossos instintos, levando-nos à criação de concepções religiosas, políticas, sociais, por demais prejudiciais.

É sabido que Freud, durante parte da sua vida, considerou o inconsciente como essencialmente bestial, sendo admitido que as concepções de Nietzsche, http://pt.wikipedia.org/wiki/Super-Homem_(filosofia), devem ter contribuído para isso, pois o super-homem é um assassino lúbrico, ao qual falta por completo o sentimento de culpabilidade. Também aos pais da horda primitiva, segundo Darwin, tudo era permitido, devorando eles os próprios filhos e matando as mulheres em proveito do seu prazer pessoal. Eu não compreendo por que essas concepções da brutalidade e da bestialidade do homem primitivo saõ tão exploradas em trabalhos de etnologia ou antropologia cultural, apesar de estarem em contradição com o que se pode observar diretamente na natureza, inclusive em relação aos animais. Tem havido nisso, provavelmente, um erro conservado pela tradição, que se vem repetindo, como é tão freqüente em trabalhos que se baseiam nos de autores precedentes. A História encontra-se cheia de exemplos desse gênero e é possível que também assim possa ser este explicado. Na verdade, porém, a Biologia ensina-nos que o fenômeno é muito diferente, sendo o ser humano primitivo caracterizado pela sua simplicidade e o seu humanismo. Além disso, muitas concepções religiosas e sociais, vindas de tempos remotos, falam no mesmo sentido. Na doutrina de Confúcio, a piedade em relação aos pais e aos avós é a única lei transcendental. Também o judaísmo e outras religiões menos antigas esposam pontos-de-vista semelhantes. Temos mostrado repetidamente que é a razão que tem desvirtuado os instintos, tornando-os desumanos e bestiais.

Apesar disso, não se pode estar de acordo com a afirmação de Freud quando admite que a civilização deixaria de existir, caso fizesse o homem tudo que lhe agrada(http://www.triplov.com/surreal/2006/JCarlos-Brito.htm). Há nisso um exagero absurdo, porque, afinal, o homem não é um criminoso que só procura o mal e a destruição. Esse pensamento é por demais consciente, tendo sido explorado até em direção filosófica. Mas deve estar completamente errado, porque o que comando os instintos é muito diferente, sendo eles que têm permitido a vida e a felicidade do homem e dos animais. São os instintos que precisam ser levados em consideração, devendo ser calcados sobre eles as exigências da nossa existência. Tem sido esse o principal leitmotiv de diversos dos nossos trabalhos, exposto sob variadas modalidades. O ditado “primeiramente viver, depois filosofar” encontra-se quase invertido, pois estamos procurando guiar a nossa vida pelo pensamento, apesar de o pensamento não ser senão uma das manifestações da vida, uma das mais tardias e, certamente, das que se têm tornado mais artificiais.

Num editorial do The Journal of American Medical Association, de 24 vde março de 1962, sobre povos primitivos e como devem ser eles julgados, é levantada, em primeiro lugar, a questão relativa ao que deve ser chamado de primitivo. A resposta é de que esses povos, em comparação aos atuais, estão ainda, sob alguns pontos-de-vista, menos desenvolvidos, por exemplo em relação a ler e escrever, a progressos técnicos e também, sob alguns aspectos, ao desenvolvimento moral e institucional. – “Mas é preciso acentuar que, sob certos ângulos, essas culturas primitivas encontrm-se mais desenvolvidas que muitas das culturas civilizadas, sendo aquelas, em alguns pontos, melhores que estas. Tomando em consideração esquimós e aborígines australianos – duas das culturas mais primitivas conhecidas dos antropologistas – verifica-se que os seus membros são muito mais generosos, afetuosos e cooperativos que a maioria dos das sociedades civilizadas. Segundo a nossa própria maneira de julgar esses valores, são eles melhores ou mais elevados entre aqueles primitivos do que entre nós, os civilizados. Os membros daquelas duas culturas primitivas são mais honestos, mais prestativos, mais alegres e mais corajosos do que habitualmente são os civilizados”. Nessa mesma publicação é mostrado quanto tem sido errôneo o julgamento dos civilizados em relação aos povos primitivos, criando opiniões que prevalecem apesar de falsas ou absurdas.

O que é preciso, todavia, é viver a vida como ela é, em toda a sua beleza e simplicidade, sem desvirtuá-la por falsas concepções e absurdas exigências. Esse deve ser o nosso caminho, caminho que precisamos trilhar com dignidade, visando à nossa grandeza e felicidade.

O homem, pela linguagem e a criação de instrumentos, tornou-se o senhor do mundo, quase sem perceber que a bondade e o altruísmo fazem parte do seu equipamento biológico, provindo dos seus longínquos antepassados, quer humanos, quer animais.

POSTED BY SELETINOF AT 11:02 PM

DUVIDAR E INVESTIGAR

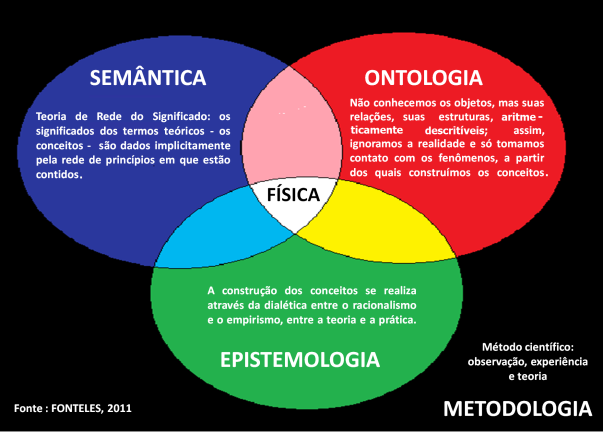

A PROBLEMÁTICA EPISTEMOLÓGICO-TEÓRICA DO DIMENSIONALISMO

Por PEDRO DE ANDRADE

ATALAIA – Revista do CICTSUL

Centro Interdisciplinar de Ciência, Tecnologia e Sociedade

da Universidade de Lisboa.

RESUMO

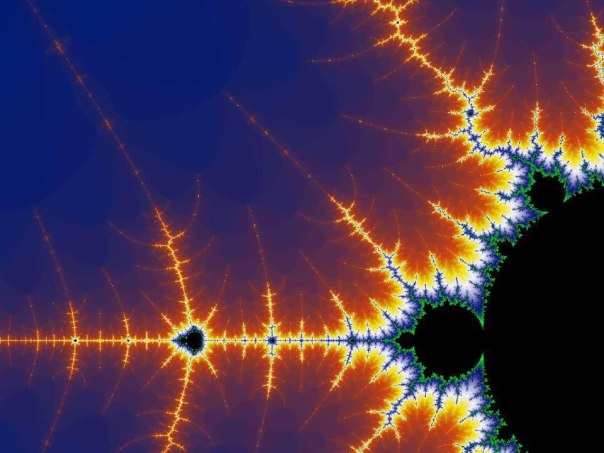

A problemática do dimensionalismo percorre o inconsciente de múltiplos autores contemporâneos, a tal ponto que podemos considerar o épistémé do dimensionalismo como aquele que define, em última análise, o modo de pensar da nossa época. O dimensionalismo é a interpretação da realidade através das suas diversas dimensões, e não apenas a partir de uma dimensão privilegiada. O espaço e o tempo entendem-se enquanto dimensões fundadoras de todas as outras, ou meta-dimensões. As relações entre o espaço e o tempo, ou entre outras dimensões, foram reformuladas, menos ou mais directamente, por Einstein, Hawking, Foucault, David Harvey, Jean Baudrillard, Paul Virilio, entre outros. É possível, pois, empreender uma genealogia do dimensionalismo. Em particular, a realidade social encerra uma natureza interdimensional e reticular, onde se escondem os buracos negros do social, e onde a diacronia passa por dobras do tempo. No quadro desta polifonia da contemporaneidade, as escritas social e sociológica desenvolvem, inevitavelmente, uma estratégia de fractalidade.

________________________________________________________________________________________________________________________________________________________________________________________

1. O dimensionalismo na epistemologia e nas ciências.

Se retomarmos um conceito de Thomas Kuhn, talvez a ‘revolução científica’ operada por Einstein seja muito mais do que isso. Como se sabe, Einstein destaca-se na cena do pensamento, ainda mais do que pela teoria científica da relatividade, devido ao contributo epistemológico que permitiu. Ele é, a meu ver, o grande iniciador daquilo que nomearia a problemática do dimensionalismo, ou seja, a reflexão sobre a dimensionalidade do real em geral, e em particular no campo social da teoria e no âmbito da sua aplicação empírica.

Para Einstein, o mundo “… é composto de acontecimentos individuais onde cada um é determinado por quatro números, a saber três coordenadas de espaço x, y, z e uma coordenada de tempo t. (…) Não estamos habituados a considerar o mundo como um continuum de quatro dimensões, porque na Física pré-relativista o tempo preenchia, em relação às coordenadas do espaço, um papel diferente e mais independente. (…) Graças à Teoria da relatividade, a concepção do ‘mundo’ em quatro dimensões torna-se perfeitamente natural, porque, nessa teoria, o tempo é privado da sua independência. “ (Einstein, 2001 : 77-8)(1). Mais precisamente, este físico desenvolveu duas teorias da relatividade, a segunda pretendendo aperfeiçoar o carácter de relatividade ainda esboçado na primeira. (Idem: 1981 : 155)(2). Estes fenómenos permitiram a descoberta dos campos de gravitação, que darão origem à teoria dos campos de gravitação.

Por seu lado, Jean Piaget, no quadro da reflexão sobre os métodos científicos de construção e intuição das noções da Física, debruçando-se sobre a interpretação das relações espaciais pela microfísica, articula os níveis macro e o micro, ao comentar as possibilidades de “… verificação da interpretação epistemológica segundo a qual o espaço físico e o tempo resultam tanto das acções efectuadas pelo sujeito à nossa escala quanto dos caracteres globais próprios aos objectos macroscópicos.“ (Piaget, 1974 : 230)(3). No quadro da epistemologia das Ciências Sociais, esta relação macro / micro revela-se uma das mais importantes nos debates contemporâneos.

Na Breve História do Tempo, Stephen Hawking recenseia e esclarece as nossas ideias do tempo, desde a noção do tempo absoluto à teoria da relatividade, que sublinhou, na Ciência, o tempo do observador. “Quando se tentou unificar a gravidade com a mecânica quântica, foi preciso introduzir a noção de tempo ‘imaginário’. O tempo imaginário não se distingue das direcções no espaço.” Ou seja, pode percorrer-se o tempo de uma forma algo espacial, para diante e para trás, para norte e para sul. “Por outro lado, quando se olha para o tempo ‘real’, há uma diferença entre os sentidos para diante e para trás.“ Isto é, lembramo-nos do passado, mas não do futuro, que não conseguimos ‘percorrer’. (Hawking, 1995, 193-4)(4).

Para além disso, o conceito einsteiniano de ‘seta do tempo’ permite precisar a relação entre estas e outras formas do tempo. (Ibidem : 195)(5). Para nós, a seta sociológica exprime, essencialmente, o tempo sócio-histórico, uma das meta-dimensões que permitem explicar o mundo social, para além do espaço sócio-histórico.

Aliás, esta problemática do dimensionalismo percorre o inconsciente de muitos outros analistas da história das Ciências, e das Ciências Sociais e Humanas em particular, como Michel Foucault. “É preciso representar o domínio do épistémè moderno como um espaço volumoso e aberto segundo três dimensões: sobre uma delas, situaríamos as ciências matemáticas e físicas, para as quais a ordem é sempre a cadeia discursiva e linear das proposições evidentes e verificadas; haveria, numa outra dimensão as ciências (como as de linguagem, da vida, da produção e da distribuição das riquezas) (…) Quanto à terceira dimensão, seria a da reflexão filosófica (…) Deste triedro epistemológico, as ciências humanas são excluídas, pelo menos no sentido em que não as podemos encontrar em nenhuma das dimensões nem na superfície dos planos assim desenhados. Mas podemos dizer também que elas estão incluídas nesse triedro, porque é nos interstícios destes saberes, mais exactamente no volume definido pelas suas três dimensões, que encontram o seu lugar. Esta situação coloca-os em relação com todas as outras formas de saberes. “(Foucault,1966: 358)(6).

De alguma forma, o épistémè moderno – e Foucault parcialmente, na sua análise – utilizam um modelo que corresponde, grosso modo, à geometria Euclidiana e, mais exactamente, à geometria analítica cartesiana, de onde derivam muitas das nossas técnicas estatísticas actuais, como a análise factorial e a própria técnica conhecida como análise multidimensional.

Entretanto, encontramo-nos hoje num mundo onde não existem três, nem mesmo quatro dimensões da realidade. As dimensões do mundo revelam-se incomensuráveis, o que não impede de as vislumbrarmos não como um triedro, mas como um prisma multifacetado, em que a pluralidade e a polifonia das várias figuras da realidade possam ser, se não demonstradas ou representadas, como alguma modernidade pretende, pelo menos fugazmente mostradas ou indiciadas. Trata-se de um exercício de captação das resmas do real e do irreal, um Livro do Mundo sem capa nem número finito de páginas, escrito por uma heurística não apenas dedicada às presenças mas também às ausências ou buracos negros, a partir dos vestígios com que a realidade e as suas máscaras se aparentam vestir. Apanhar os troços pelos traços, os restos pelos rastos, os projectos e os seus projécteis pelas projecções.

Retomando Foucault: “Não há dúvida que a emergência histórica de cada uma das ciências humanas fez-se na ocasião de um problema, de uma exigência, de um obstáculo de ordem teórica ou prática.” (Ibidem: 356) Dito de outro modo: é necessário empreender uma genealogia do dimensionalismo, aqui apenas esquissada.

Aliás, se essa genealogia ainda se encontra por fazer, a Filosofia, as Ciências Humanas e as Ciências Sociais, sem o nomearem explicitamente, já se encontram a reflectir na problemática do dimensionalismo.

A este propósito, por um lado, quanto às temporalidades, uma obra aliciante mas também polémica, foi escrito por W. Newton-Smith, onde se percorre: a natureza do tempo; a mudança; a topologia do tempo (entendida nos parâmetros da linearidade, da unidade, do início e dos micro-aspectos); a métrica do tempo e a sua direcção. Em especial, o autor pretende ultrapassar a dualidade entre a posição daqueles que significam o tempo como contentor dos acontecimentos, ou absolutistas; e aqueles para quem o tempo não pode existir sem os eventos, ou relativistas. Para ele, o tempo pode mostrar-se cíclico, estabelecer ‘branchings’ ou seja, conectividade; existem tempos com ou sem começo, etc. Para além disso, o tempo apresenta-se como uma ‘estrutura teórica’ (theoretical structure) ou como um quadro teórico (theoretical framework). “Nesta acepção, as hipóteses acerca do tempo não são entendidas como representando hipóteses acerca dos factos, mas especificando modos de descrição para lidar com os factos. “ (Newton-Smith, 1984 : 239)(7). A sociologia também se interessa por esta problemática do tempo, sobretudo a partir de Anthony Giddens, David Harvey, Nikhlas Luhmann e Erving Goffman (8).

Por outro lado, a questão do espaço, e da ‘espacialidade’ em particular, recobre pelo menos quatro sentidos. Em primeiro lugar, no quadro do existencialismo e da fenomenologia de Heidegger e Husserl, J. Pickles aponta a espacialidade humana como pré-condição de qualquer compreensão dos lugares e dos espaços como tal. Nas nossas actividades quotidianas, não experimentamos abstracções cognitivas de objectos separados, mas constelações de relações e de sentido, o ‘equipamento ‘ segundo Heidegger, que se encontra ‘pronto para uso’ em ‘contextos de equipamentos’ (9).

Em segundo lugar, no âmbito do marxismo estruturalista, procura-se estabelecer a relação entre estruturas sociais e estruturas espaciais. Louis Althusser alega que as diferentes construções do tempo ou ‘temporalidades’ podem ser associadas a outros tantos planos dos modos de produção, resultando no ‘tempo económico’, no ‘tempo político’ ou no ‘tempo ideológico’. Contudo, Pierre Vilar sustenta que a história não articula apenas tempos mas ‘espacialidades’, também conectáveis aos níveis dos modos de produção (10). Por seu turno, A. Lipietz advoga uma correspondência entre a ‘presença-ausência’ no espaço e a ‘participação-exclusão’ nas práticas sociais (11). Neste quadro conceptual, Manuel Castells apresentou a mais completa sistematização das correspondências entre estruturas sociais e estruturas espaciais, mas acrescentando que não podemos falar dessas instâncias separadamente, apenas é possível referirmo-nos a espaços-tempos, que são conjunturas construídos pela história (12).

Em terceiro lugar, Edward Soja, inspirado em Henri Lefebvre e no seu conceito ‘produção do espaço’, afirma que nem todo o espaço é socialmente produzido, apenas a ‘espacialidade’. Aproximando-se ainda da teoria da estrutruração de Anthony Giddens, fala de uma ‘estruturação espácio-temporal’ (Soja, 1985 :1984 : 90-122) (13).

Em quarto lugar, alguns autores pós-estruturalistas, a partir de Deleuze e Foucault, referem-se a constelações de poder e saber inscritas nos espaços, a partir dos quais os posicionamentos e as identidades dos sujeitos são construídas (14).

Para além disso, de entre os autores que mais aproximam o espaço ao tempo, questão que nos interessa particularmente aqui, Giddens, a partir da ‘geografia do tempo’ desenvolvida por Torsten Hagerstrand, sugere a ‘distanciação tempo-espaço’, como sendo a expansão da interacção através do espaço e a sua contracção através do tempo, processo que influi nos outros fenómenos sociais: “Proponho que a noção de distanciação espaço-tempo se conecte, de uma maneira muito directa, com a teoria do poder. Explorando esta conexão podemos elaborar alguns dos contornos principais da dominação enquanto propriedade expansível dos sistemas sociais.” (Giddens, 1991: 258) (15). Por seu lado, David Harvey fala de ‘compressão tempo-espaço’, ou seja, a aniquilação do espaço pelo tempo sob o capitalismo, já entrevista por Marx, mas caracterizada por Harvey em termos de uma velocidade no ritmo da vida, que sugere o colapso do mundo em cada sujeito. Em particular, Harvey preocupa-se com o modo pelo qual a ‘compressão tempo espaço’ desloca o habitus. (Harvey, 1989, pp. 242-7) (16). Existe, pois, neste último autor, uma dimensão de experiência subjectiva e de crise de identidade que a noção ‘distanciação tempo-espaço’ de Giddens não traduz, pelo menos tão claramente.

Por seu turno, Jean Baudrillard refere-se pontualmente às dimensões, numa entrevista a Yves Laurent. “ [Baudrillard : ] — Um ser a duas dimensões, como a imagem, é em si perfeito. (Baudrillard, 2001: 99) (17). A terceira dimensão é uma forma de denegação da imagem. Com a quarta, com o virtual, temos um espaço-tempo que já não tem nenhuma dimensão…” (Ibidem : 100-1) (18). O autor acrescenta ainda: “Se quisermos voltar ao mais próximo da essência de um objecto estético, (…) é necessário subtrair, sempre subtrair …” (Ibidem; 101). A meu ver, Baudrillard, malgrado o interesse manifesto da sua análise, decididamente, pára de contar no zero. Se continuasse a subtrair, ultrapassaria o zero e chegaria à multiplicidade de dimensões negativas, o que não deixa de ser uma subtracção, que agora leva à multiplicidade de dimensões.

Baudrillard faz coincidir as quatro dimensões do virtual com a ‘realidade integral’, ou seja, a hiperrealidade. “O universo de três dimensões tornou-se agora flutuante, submergido por um universo de quatro dimensões, o do virtual, do digital, aquilo que chamo a realidade integral. “ (Ibidem : 102). No écran, o problema da profundidade não se coloca, não há o outro lado do écran, enquanto que existe um outro lado do espelho. (…) há felizmente excepções. Qualquer imagem verdadeira, qualquer fotografia verdadeira só vale como excepção …” No entanto, Baudrillard, a propósito desta redução às duas dimensões da imagem e à unicidade desta última, diz que “isso colocou-me um problema para a exposição fotográfica: ‘A morte da imagem’, onde expunha séries, portanto em total contradição com o que lhe digo . (…) Depois de falar da singularidade da imagem, do universo de duas dimensões, irredutível ao de três dimensões [o nível da realidade, da representação, segundo Baudrillard], encontro-me a usar a série, que é para a imagem uma maneira de entrar na quarta dimensão, aquela do fractal [e do virtual, do digital, da realidade integral, segundo o autor], e que faz parte, portanto, da morte da imagem . “ (Ibidem : 103-4).

No fundo, perpassa um certo dualismo, algo moderno, nesta interpretação, por parte de Baudrillard, da dimensionalidade do real. Mais, não nos parece que possa existir uma realidade ‘ideal’ a duas dimensões, aquela precisamente subjacente à generalizada ‘écranização da vida’ de que falam tantos analistas. Igualmente, a realidade ‘integral’ a 4 dimensões, a que investe na ‘virtualização da vida’, surge apenas como uma das ‘realidades integrais’ possíveis. Mais interessantes parecem ser as ‘realidades polifónicas’, ainda em construção, cada uma das quais mostradas – apresentadas mas já não representadas – , nas combinações singulares das dimensões da realidade e da irrealidade.

Para além disso, como bem recorda John Armitage, Paul Virilio interessa-se pela teoria da relatividade de Einstein, embora esse aspecto seja um dos menos considerados na apreciação do seu pensamento (19). “Nós encontramo-nos todos a atravessar os portões da relatividade. É sobejamente sabido que a teoria da relatividade está muito pouco popularizada, não é nada bem compreendida pelo público em geral. Mas não podemos ignorar a teoria da relatividade pela mera razão de que é de difícil compreensão. Porquê? Porque a vivemos. Nós vivemo-la através dos telemóveis, por meio dos programas ‘ao vivo’ na TV, por intermédio das telecomunicações, através da realidade virtual (VR), pelo ciberespaço, por meio da ciberconferência, pela mediação da viagem aérea supersónica, e assim por diante. Portanto, à medida que a vivemos, interpretamo-la, no sentido musical do termo. “(Armitage, 2001 : 17) (20). Esta relatividade advém, em grande parte, das deslocalizações operadas pela velocidade das comunicações planetárias. (Ibidem : 18) (21).

Paul Virilio irá, assim, circunscrever melhor a intervenção das dimensões espaciais e temporais na cena contemporânea: “Tempo (duração), espaço (extensão), a partir de agora inconcebíveis sem a luz (velocidade-limite), a constante cosmológica da velocidade da luz, contingência filosófica absoluta que sucede depois de Einstein ao carácter absoluto concedido por Newton e por muitos antes dele ao espaço e ao tempo. “ (Virilio, 2000:35) (22).Outro conceito importante, em articulação estreita com as anteriores dimensões, refere-se à sua crise no pensamento e na acção. “A transição crítica não é, pois, uma palavra vã: dissimula-se atrás deste vocábulo uma verdadeira crise da dimensão temporal da acção imediata. Depois da crise das dimensões espaciais ‘inteiras’, em favor da acrescida importância das dimensões fraccionadas, vai assistir-se, finalmente, à crise da dimensão temporal do instante presente.“ (Ibidem : 37).

Daí que Paul Virilio detecte um novo tipo de processos sociais, assim circunscritos: “Ao lado dos fenómenos da poluição atmosférica, hidrosférica e outras, existe um fenómeno de poluição despercebido, o da poluição da extensão, ao qual proponho chamar dromosférico – de dromos : corrida.” (Ibidem:47). Desta maneira, a velocidade e o percurso, e mesmo o percurso da velocidade, fundam-se e fundem-se, para Virilio, mais no tempo do que no espaço: “Ora, de que ‘espacialidade’ pode tratar-se quando já só subsiste o ser do trajecto, de um ‘trajecto’ que se identifica integralmente ao sujeito e os objecto em movimento, sem outra referência que não ele próprio? “ (Ibidem:171).

Um tal protagonismo do tempo é inegável. Contudo, parece-me mais rigoroso afirmar que a paisagem actual rege-se por inéditas espacializações de tempo e por temporalizações originais do espaço, devido à proliferação desmesurada e incomensurável de novas dimensões do real e, sobretudo, de novas relações entre elas. Neste sentido, em 1985, tinha sugerido a emergência de um tipo de saber nunca dantes visto, o ‘saber-dados’, que conectámos recentemente ao conceito valor informativo-textual (23). O saber-dados é o conhecimento nativo produzido nos sistemas informáticos e nas redes de informação, que se relaciona intimamente com todos os outros modos de conhecimento, afirmando-se mesmo como uma espécie de ‘saber-moeda’, equivalente geral dos restantes. Mais tarde, em Janeiro de 1996, propus a noção de cibertempo, a fim de acentuar não apenas o protagonismo das temporalidades, mas para as redimensionalizar com as espacialidades e as restantes dimensões, e em especial com o ciberespaço (24).

Também José Augusto Mourão aponta a necessidade de uma atenção acrescida à relatividade, em particular a interacção e o dialogismo reticulares entre o sujeito observador e o objecto observado, no quadro dos textos e o dos seus contextos. “Em 1913, Albert Einstein publicou a sua Teoria Geral da Relatividade. De acordo com esta teoria, a distinção entre actores e palco já não seria possível. O período moderno (i.e. de cerca de 1875 a 1925) assistiu a uma transformação radical na anterior noção de texto. O texto torna-se um objecto a obter, um texto dialógico. “ (Mourão, 2001 : 65) (25). Uma tal dimensão dialógica e textual da relatividade parece-me central.

Assim, se emigrarmos para Mikhail Bakhtine, o propulsor do dialogismo, encontramos o termo ‘cronótopo’, que significa as instâncias espaciais e temporais que intervém no texto narrativo, mediadas pelos códigos técnico-literários. Por exemplo, o autor mostra que, em meados do século XVIII, certas localizações geográficas condicionaram ‘cultos locais’ associados com trabalhos literários específicos, que aliás tetemunham um novo sentido de espaço e do tempo no trabalho artístico. (Bakhtine, 1986 : 47) (26).

Nesta perspectiva, a literatura e as linguagens são entendidas como sistemas mutantes de subgéneros e de linguagens fragmentadas, em luta umas com as outras, em contextos espácio-temporais onde os agentes e a arte dialogam e se hibridizam. Na Imaginação Dialógica, encontramos a caracterização das formas do tempo e do cronótopo na novela (Idem, 1990 : 41-83) (27). Os outros géneros, como o épico, são ‘géneros completos’ (Ibidem : 7), na medida em que encontram-se referidos, pelo menos no seu apogeu, a realidades sócio-culturais passadas. “…A interacção mútua dos géneros num único período literário unificado é um problema de grande interesse e importância.” (Ibidem: 4). “… De todos os géneros maiores apenas a novela é mais nova do que a escrita e o livro: só ela se encontra receptiva organicamente a novas formas de percepção muda, isto é, de leitura.” (Ibidem : 3) Hoje, processa-se uma ‘novelização’ (novelization) dos outros géneros, a partir da ‘novelidade’ (novelness) em estreita relação com as características temporais e espaciais ou sócio-culturais da cena contemporânea. “Quais são os traços salientes desta novelização dos outros géneros? Tornam-se mais livres e flexíveis, a sua linguagem renova-se pela incorporação de heteroglossias extra-literárias e os níveis ‘novelísticos’ da linguagem literária tornam-se dialogizados, permeados com risos, humor, elementos de auto-paródia e finalmente – isto é o mais importante – a novela insere, nestes outros géneros, uma indeterminação, uma certa abertura semântica, um contacto vivido com uma realidade contemporânea envolvente inacabada (o presente ilimitado)”. (Ibidem : 6-7).

Este conceito, ‘cronótopo’, aplica-se, com proveito, aos estudos sociológicos. Aliás, Lynne Pearce sugeriu uma sua extensão, a partir do hibridação desse termo com outra noção de Bakhtine, o ‘polifónico’, no vocábulo ‘policronotópico’. A palavra significa a coexistência de múltiplos cronótopos, cada um possuindo uma certa autonomia, num mesmo texto: “…sem sempre coincidirem, os cronótopos entram num diálogo complexo uns com os outros, que é, em todos os tempos, um diálogo inscrito pelo poder.” (Pearce, 1994 : 175) (28).

2. A fractalidade das escritas social e sociológica

Um outro aspecto importante na dimensionalização da natureza e da sociedade, e proximamente relacionado com a noção e questão das escritas social e sociológica, é a sua fractalidade. Sabemos que o fractal é uma organização de entidades que progride pela produção de formas semelhantes em escalas dissemelhantes. Benoit Mandelbrot defende que as paisagens geográficas e outros aspectos dos sistemas naturais possuem propriedades fractais (29). Por seu turno, M. Batty e P. Longley aplicam fractais em modelos formais e de crescimento das cidades, argumentando que, em diferentes escalas, o tecido urbano apresenta semelhanças (30). M. Goodchild e D. Mark, aproximam as formas fractais aos fenómenos geográficos e respectivos sistemas de informação (GIS). (1987 : 265-78) (31). Em particular, Edward Soja, a este propósito, desenvolve o conceito de ‘pós-metrópolis’: “O spatial turn foi a mais recente adição ao discurso especializado da nova política da cultura (…) Escolhi o termo cidade fractal para descrever o mosaico social reestructurado da pós-metropolis. (…) Adoptando uma perspectiva espacial ternária permite-nos ver em qualquer sítio empírico, desde o corpo à esfera global, a natureza fundamental da espacialidade da natureza humana em toda a sua riqueza e complexidade, em grande parte como uma biografia individual ou uma história social abre possibilidades para a consideração de todos os aspectos da condição humana geral. “ (Soja, 2000 : 281-283) (32).

Entretanto, no decurso de uma entrevista concedida por Baudrillard a Yves Laurent, ambos estabelecem a separação entre o fragmento e o fractal : “ Segundo Musil, o fragmento é o mais pequeno todo possível. Rokhto diz – falando da sua obra – que aquilo que a caracteriza é que ela se abre em todas as direcções (…) ao mesmo tempo que se fecha (…) gosto muito desta imagem: fechar-se em todas as direcções…Aí está, parece-me aquilo que é um fragmento. Fecha-se em todas as direcções, ao passo que o fractal não abre mais do que aquilo que fecha…” (Baudrillard, 2001: 104) (33). A meu ver, não há fractal sem fracturação em múltiplas formas, no seio do próprio fractal. Com efeito, o fractal não engendra apenas a clonagem de uma mesma figura. Para além disso, o fractal produz formas inéditas. Por um lado, fá-lo a nível microscópico, na forma de variações mínimas ou de relações novas entre as formas repetidas em escalas microscópicas diferentes. Por outro lado, no nível macroscópico, os efeitos da totalidade de uma tal organização da natureza ou da sociedade (o ‘desenho’ geral do fractal) relativizam-se, continuamente, devido à própria produção contínua de novas partes do fractal. Na verdade, a noção de ‘fractal finito’ é uma contradição, terminológica e lógica. Daí que a fractalidade se apresente como uma hibridação do Mesmo e do Outro. De facto, a fractalidade não se confunde totalmente com a mesmidade, porque diversifica as semelhanças do sistema através das relações de diferença (ou seja, as variações mínimas e as distintas escalas) que introduz. Da mesma maneira, não coincide completamente com a alteridade, já que a reproduz e a clona, em parte.

3. O épistémè da dimensionalidade.

Que deduzir, de um modo sintético, destas diversas contribuições epistemológicas e teóricas? Na minha perspectiva, a conclusão mais evidente é esta: aquilo que caracteriza o pensamento e a linguagem da contemporaneidade, o seu épistémè mais genuíno, é o épistémè da dimensionalidade. Mas não qualquer dimensão ou dimensionalismo simplista, ou uma dimensionalização que enfeude as dobras da realidade ou os buracos negros da não-matéria social numa gaiola física ou social. Por outras palavras, não se trata apenas de recorrer às dimensões físicas, como o espaço, o tempo, a velocidade ou a aceleração, ainda que aplicadas à sociedade. O que importa destacar é a versão interdimensional ou transdimensional do dimensionalismo, que realça não somente a multiplicidade e sobretudo a pluralidade e polissemia do real, mas assume-se enquanto poliedro teórico que relaciona as suas infindáveis dimensões sociais, onde, tal como um peixe apanhado numa rede de malhas pouco finas, o sentido escapa no próprio momento em que parece ser domesticado. Mais: para além das dimensões conhecidas, é necessário demandar aquelas nunca dantes percepcionadas, mas apenas presentes nos traços deixados nos mapas cognitivos e sémicos do futuro.

Assim sendo, uma tal hermenêutica interdimensional sublinha principalmente, duas coisas:

Primeiro, não basta professar uma bidimensionalidade, uma tridimensionalidade, nem mesmo uma multidimensionalidade. Apoiando-nos no conceito de polifonia de Milhail Bakhtine, uma polifonia das dimensões só se entende se acompanhada de uma polifonia das relações. Ou seja, as dimensões não devem ser coarctadas na sua hibridação e heteroglossia social. Por isso, extraímos do mundo não somente a dimensão ‘esferas sociais’, mas também os ‘níveis societais’ e as ‘negociações sociais’, bem como as meta-dimensões que as cruzam, como os espaços e os tempos sociais, para além de outras dimensões ainda em construção na hermenêutica interdimensional (34).

Segundo, não se assevera suficiente pensar as dimensões físicas aplicadas na realidade social, mas é preciso reflectir sobre as dimensões sociais articuladas às dimensões sociológicas. Ou seja, falta dimensionar não somente o real, mas igualmente a teoria. As relações entre as dimensões, como se verá, são essencialmente três: as relações intradimensionais, ou seja, as teias circulantes entre as zonas internas a cada dimensão; as relações interdimensionais, isto é, as redes tecidas entre duas ou mais dimensões; e as relações metadimensionais, ou os fluxos que envolvem pelo menos uma meta-dimensão.

________________________________________________________________________________________________________________________________________________________________________________________

NOTAS

1. Albert Einstein, 2001, La relativité, Paris, Payot.

2. De acordo com a teoria da relatividade restrita, as coordenadas de espaço e de tempo ainda conservam um carácter absoluto, já que são directamente mensuráveis pelos relógios e corpos rígidos. Mas tornam-se relativos por dependerem do estado de movimento do sistema de inércia escolhido.“ Ou seja, no quadro da relatividade restrita, cada sistema de inércia possui o seu tempo particular e relativo. Pelo contrário, a teoria da relatividade geral estende o “… princípio de relatividade aos sistemas de coordenadas [as quatro dimensões do mundo], possuidores de uma aceleração relativa de uns em relação aos outros.“ (Albert Einstein, 1981, Como vejo o mundo, Rio de Janeiro, Nova Fronteira).

3. Jean Piaget, 1974, Introduction à l’épistemologie génétique: 2. La pensée physique, Paris, PUF.

4. Stephen Hawking, 1995, Breve História do tempo, Do Big Bang aos buracos negros, Lisboa, Gradiva.

5. “O aumento de desordem ou entropia com o tempo é um exemplo do que se chama uma seta do tempo, qualquer coisa que distingue o passado do futuro, dando um sentido ao tempo. Há pelo menos três setas diferentes do tempo. Primeiro há a seta termodinâmica, o sentido do tempo em que a desordem ou entropia aumenta. Depois há a seta psicológica, ou seja, o sentido em que sentimos que o tempo passa, em que nos lembramos do passado mas não do futuro. Finalmente, há a seta cosmológica, que é o sentido do tempo em que o Universo está a expandir-se em vez de contrair-se.“

6. Michel Foucault, 1966, Les mots et les choses, Paris, Gallimard.

7. W. Newton-Smith, 1984, The Structure of Time, London, Routledge.

8. Para uma síntese das teorias do tempo social, cf: Simonetta Tabboni, 1989, La representazione sociale del tempo, Milano, Franco Angeli, sobretudo as páginas 185-214.

9. J. Pickles, 1985, Phenomenology, science and geography: spartiality and the human sciences, Cambridge University Press.

10. Pierre Vilar, 1973, « Histoire marxiste, histoire en construction : essai de dialogue avec Althusser », Annales ESC (28), pp. 165-98.

11. A. Lipietz, 1977, Le capital et son espace, Paris, Maspero.

12. Manuel Castells, 1977, The urban question, London, Edward Arnold.

13. Edward Soja, 1985, “The spatiality of social life: towards a transformative retheorization”, In D. Gregory; J. Urry (eds.) Social relations and spatial structures, London, MacMillan.

14. D. Gegory, 1994, Geographical Imagination, Oxford / Cambridge, Blackwell.

15. Anthony Giddens, 1991, The Constitution of Society: Outline of the Theory of Structuration, Camberidge, Polity Press.

16. David Harvey, 1989, The Condition of Post-Modernity : an enquiry into the conditions of cultural change, Oxford, Blackwell.

17. Jean Baudrillard, 2001, D’ un fragment à l’autre : entretiens avec Yves Laurent, Paris, Albin Michel.

18. (…) O facto de que a imagem seja a duas dimensões, agrada-me, na medida em que isso alcança – por razões que me são confusas – a ideia de dualidade… [Entrevistador:] —- O seu fundo gnóstico… [Baudrillard : ] — Deve ser isso! Parece-me que a ordem simbólica é dual, e nesse sentido, e que todas as ordens que se conhece são pelo contrário, unitárias, totalitárias… “ (…) “ De qualquer maneira, procura-se no universo do som como naquele da imagem, o acrescento de novas dimensões, uma trifonia, depois uma quadrifonia, depois uma multifonia. Na imagem, é a mesma coisa, damos-lhe uma, duas, três, várias dimensões.

19. Paul Virilio, 1997, Open Sky, London, Verso. John Armitage, 2001, Virilio Live: Selected Interviews, London, Sage.

20. John Armitage, 2001, Virilio Live: Selected Interviews, London, Sage.

21. “Tornámo-nos desterritorializados. A nossa incrustação em solo nativo, esse elemento do hic et nunc, (aqui e agora), ‘in situ’, essa inserção pertence, agora, em certa medida, ao passado. Foi superada pela aceleração da história – pela aceleração da própria realidade – pelo ‘tempo real’, e pela ‘vida’, conjunto que se posiciona para além do hic et nunc, condição ‘in situ. (…) Só relatividade! Não a relatividade dos físicos, mas a nossa relatividade, a relatividade das nossas próprias vidas vividas, pelas quais somos responsáveis, e das quais somos as vítimas, ao mesmo tempo. A relatividade já não é o domínio exclusivo do cientistas (naturais), tornou-se propriedade de todos aqueles que vivem no mundo moderno.“

22. Paul Virilio, 2000, A velocidade de libertação, Lisboa, Relógio de Água.

23. Pedro Andrade, 1985, “Para uma Sociologia da Documentação: sensibilização à necessidade da sua construção”, In Actas do 1º Congresso Nacional de Bibliotecários, Arquivistas e Documentalistas ‘A informação em tempo de mudança’, Porto, 19-21/6/85, pp. 421-450.

24. Idem, 1996, “Para uma Sociologia (Interdimensional) da Internet”, In Actas do 3º Congresso Português de Sociologia, 7-9 Fev. [Editado em CD-ROM].

25. José Augusto Mourão, 2001, Para uma poética do hipertexto: a ficção interactiva, Lisboa, Edições Universitárias Lusófonas.

26. Mikhail Bakhtine, 1986, Speech genres and Other Late Essays, Austin, University of Texas Press.

27. Idem, 1990, The Dialogical Imagination: Four Essays with Problems of Dostoevsky’s Poetics, Austin, University of Texas Press.

28. Lynne Pearce, 1994, Reading Dialogics, London, Arnold.

29. B. Mandelbrot, 1982, The fractal geometry of nature, W. H, Freeman, San Francisco.

30. M. Batty; P. Longley, 1994, Fractal cities, London, Academic Press.

31. M. Goodchild; D. Mark, 1987, “The fractal nature of geographic phenomena”, Annals of the Association of American Geographers (77).

32. Edward Soja, 2001, Postmetropolis: Critical Studies of Cities and Regions, Oxford, Blackwell.

33. Jean Baudrillard, 2001, D’ un fragment à l’autre : entretiens avec Yves Laurent, Paris, Albin Michel.

34. A primeira formulação da Hermenêutica e Sociologia Interdimensionais, tal como a concebemos, foi proposta em Pedro de Andrade, 1993, “As sonoridades sociais”, In Actas do 2º Congresso Português de Sociologia. Lisboa, 5-7/2/92, 82-105. Esta questão será retomada e actualizada no próximo número de Atalaia/Intermundos.

_______________________________________________________________________________

FontePesquisa:

1.<http://www.triplov.com/atalaia/pedro_andrade.html>

2. <http://www.edi-colibri.pt/Detalhes.aspx?ItemID=104>

POSTED BY SELETINOF AT9:34 PM

TEMPO IMAGINÁRIO

Postamos, aqui, o relato de Gregory Benford, colaborador da "Reason Magazine" e professor de física na Universidade da Califórnia em Irvine, sobre o diálogo que teve com Stephen Hawking, no escritório deste em Cambridge, abordando vários temas da física, além, claro, do tempo imaginário, o qual fora proposto por Hawking no sentido de estabelecer critérios para a moldagem do tempo pela mecânica quântica.

Stephen Hawking parecia estar um pouco pior, como sempre. É um milagre que continue se agarrando à vida, mesmo depois de 20 anos sofrendo da doença de Lou Gehrig. Cada vez que o vejo, penso que será a última, que não conseguirá continuar agarrado a um fio tão frágil por muito mais tempo.

Hawking completou 60 anos em janeiro. Ao longo de sua brilhante carreira, ele destrinchou os pontos básicos da física dos buracos negros, incluindo, mais notavelmente, sua previsão segundo a qual os buracos negros não são inteiramente negros. Em lugar disso, se possuírem massa equivalente à de uma montanha, vão irradiar partículas de todo tipo. Buracos menores desapareceriam num clarão de radiação -uma assinatura pela qual os astrônomos vêm procurando, mas que, até agora, não encontraram.

O enorme sucesso de seu livro "Uma Breve História do Tempo", de 1988, transformou Hawking numa espécie curiosa de ícone cultural. Ele se pergunta quantos dos roqueiros e das estrelas de cinema menores que já mencionaram o livro em "talk shows" realmente o leram.

Com seu último livro, "O Universo numa Casca de Noz", Hawking procura mudar essa situação, oferecendo uma multidão de ilustrações de fácil compreensão para ajudar os leitores a apreender tópicos complexos, tais como a teoria das supercordas e a natureza do tempo. O segredo consiste em traduzir equações em sentenças, o que não é muito fácil. As ilustrações ajudam muito, embora puristas as deplorem. Quanto a mim, acho que qualquer artifício se justifica, quando se trata de lançar uma ponte sobre um abismo tão profundo.

Quando entrei no escritório de Stephen em Cambridge, as pessoas manifestaram cautela, evidentemente suspeitando que eu fosse apenas um "civil" com alguma teoria excêntrica do Universo. Mas eu tinha telefonado antes, e sua secretária me reconhecera (sou astrofísico e conheço Stephen desde a década de 70).

Quando entrei no escritório familiar, seu corpo encolhido estava reclinado na cadeira motorizada e ele me olhava, os óculos grossos deixando seus olhos arregalados – mas uma disposição dinâmica e forte penetrava tudo o que dizia.

Hawking perdeu as cordas vocais anos atrás, vítimas de uma traqueotomia de emergência. Suas mãos retorcidas e fracas não conseguiam segurar uma caneta. Por algum tempo depois da cirurgia ele viveu totalmente isolado do mundo. Uma empresa do vale do Silício o socorreu. Engenheiros criaram softwares feitos sob medida para Hawking, fáceis de usar, além de um teclado especial.

Sua mão frágil passeava pelo teclado na velocidade de um caranguejo. Conseguia construir sentenças rapidamente, passeando pelo menu de palavras usadas com frequência exposto na tela de cristal líquido, dependurada à sua frente na cadeira de rodas. A invenção foi um sucesso tão grande que o pessoal do vale do Silício agora fornece unidades semelhantes a pessoas em todo o mundo que sofrem da mesma doença. "Por favor desculpe meu sotaque americano", disse a caixa montada atrás da cadeira de rodas, com sotaque da Califórnia. Stephen "redigiu" essa frase inteira com apenas dois toques no teclado. Stephen decolou e começou a discutir idéias sobre a origem do Universo – o momento que se seguiu ao Big Bang- que andam fazendo furor na comunidade de física.

Paradoxalmente, os extremos bons modos de Stephen me deixavam pouco à vontade. Eu tinha plena consciência de que seu tempo é curto e, afinal, só havia dado uma passadinha para falar de interesses comuns. "Durante anos, tive a impressão de que meus trabalhos iniciais com Roger Penrose eram um desastre para a ciência", disse Stephen. "Eles mostraram que, se a teoria geral da relatividade de Einstein estiver certa, o Universo deve ter começado com uma singularidade. Isso parecia indicar que a ciência não poderia prever o começo do Universo. As leis deixariam de se aplicar no ponto da singularidade, da densidade infinita".

Vamos continuar a descobrir novas camadas de estrutura, mas parece que a física vai se tornando mais simples, à medida que diminui a escala considerada.

A matemática não consegue lidar com quantidades físicas como a densidade, que vão literalmente até o infinito. Na verdade, a física do século 20 diz respeito, em grande medida, a modos de evitar as infinidades que aparecem na teoria das partículas e na cosmologia. A idéia de partículas pontuais é prática, mas leva a problemas que não têm respostas fáceis. Lembrei que havia conversado com Stephen sobre maneiras matemáticas de contornar esse problema certa noite, numa festa no King’s College.

Havia analogias a traçar com métodos da mecânica quântica elementar, métodos que Stephen estava tentando transferir para esse terreno surrealista. "Hoje, parece que a maneira como o Universo começou pode ser determinada, sim, usando o tempo imaginário", disse Stephen. Falamos um pouco dessa idéia. Stephen vinha usando um artifício matemático pelo qual o tempo, como conveniência de anotação, é substituído por algo chamado tempo imaginário. Isso muda a natureza das equações, de modo que ele poderia usar algumas idéias do minúsculo mundo quântico.

Tempo Imaginário

Nas novas equações ocorre uma espécie de "efeito túnel", pelo qual o Universo, antes do Big Bang, tem muitas maneiras diferentes de passar pela singularidade. Com o tempo imaginário, podemos calcular as chances de um túnel dado levar até nosso Universo primordial, após o início do tempo tal como o conhecemos. "Sim, as equações podem ser interpretadas assim, é claro", argumentei. "Mas, na realidade, isso é apenas um truque, não é?" Stephen respondeu: "Sim, mas é um truque que abre perspectivas, talvez".

"Não compreendemos o tempo profundamente", respondi, "então substituir o tempo real por um tempo imaginário não significa muito para nós".

"O tempo imaginário é uma nova dimensão que forma um ângulo reto com o tempo real, ordinário", explicou Stephen. "Ao longo desse eixo, se o Universo satisfizer a condição de não ter limite, poderemos fazer nossos cálculos. Essa condição diz que o Universo não tem singularidades ou fronteiras na direção imaginária do tempo. Com tal condição, não haverá começo ou fim do tempo imaginário, assim como não há começo ou fim de um caminho na superfície da Terra".

"Desde que o caminho descreva uma volta completa da Terra", respondi. "Mas, estando no tempo imaginário, não sabemos se não haverá um limite."

"Minha intuição diz que não haverá bloqueio nessa coordenada específica, de modo que nossos cálculos fazem sentido, sim".

"O problema é justamente esse, não é mesmo? Fazer sentido. O tempo imaginário é apenas uma conveniência matemática", eu disse, irritado com o abismo que separa os espaços matemáticos frios do imediatismo do mundo real. É uma tensão comum, quando se faz física. "Não guarda relação com a maneira como sentimos o tempo. Os segundos passando, o nascimento, a morte."

Interrompendo, rapidamente, este papo legal entre Benford e Hawking, citamos, aqui, uma passagem do livro, O Universo numa Casca de Noz, visando esclarecer melhor essa questão do fazer sentido: Pode-se pensar que isso significa que os números imaginários não passam de um jogo matemático, sem nenhuma relação com o mundo real. Do ponto de vista da filosofia positivista, porém, não é possível determinar o que é real. Tudo que se pode fazer é descobrir quais modelos matemáticos descrevem o universo em que vivemos. Afinal, um modelo matemático envolvendo o tempo imaginário prevê não apenas efeitos que já observamos, mas também efeitos que ainda não coseguimos medir, porém nos quais acreditamos por outros motivos. Então, o que é real e o que é imaginário? A distinção está apenas em nossas mentes?… Nos reportemos, agora, para o nosso artigo FÍSICA E REALIDADE, postagem de 17 de janeiro:

http://petroleo1961.spaces.live.com/blog/cns!7C400FA4789CE339!457.entry

Através da leitura desta publicação, acreditamos que todos possam compreender bem melhor o que Hawking quer dizer quando cita a filosofia positivista e a descrição do Universo utilizando o tempo imaginário… Voltemos, então, ao diálogo de Benford com Hawking.

"É verdade. Nossas mentes trabalham no tempo real, que começa com o Big Bang e vai terminar, se houver um Big Crunch, na grande contração – hipótese que hoje parece pouco provável, em vista dos últimos dados, que indicam a ocorrência de uma expansão em aceleração. A consciência chegaria ao fim numa singularidade."

"O que não seria um grande consolo", comentei. Stephen sorriu. "Não, mas eu gosto da condição da ausência de fronteira. Ela parece deixar implícito que o Universo se encontrará num estado de alto grau de ordem em uma extremidade do tempo real, mas estará em desordem na outra extremidade do tempo, de modo que a desordem aumenta numa direção do tempo. Definimos essa direção como sendo a direção do tempo crescente. Quando gravamos alguma coisa em nossa memória, a desordem do Universo vai aumentar. Isso explica por que lembramos apenas acontecimentos que estão no que chamamos de o passado, e não no futuro."

"Lembra o que você previu em 1980 sobre teorias finais, como essa?", disse, chamando sua atenção.

"Achei que talvez pudéssemos encontrar uma teoria unificada completa até o final do século." Stephen fez o aparelho que transforma seus toques no teclado em sons dar uma risada irônica. "OK, eu estava enganado. Naquela época, a melhor candidata parecia ser a supergravidade. Agora, parece que essa teoria pode ser uma aproximação de uma teoria mais fundamental, a das supercordas. Fui um pouco otimista demais ao esperar que pudéssemos resolver o problema até o final do século. Mas acho que ainda há uma chance de 50% de encontrar uma teoria unificada completa em 20 anos".

"Sempre desconfiei que, quando a gente adota escalas cada vez menores, a estrutura nunca termina e que as teorias também não vão terminar nunca", aventei.

"É possível que não exista uma teoria última da física. Em lugar disso, vamos continuar a descobrir novas camadas de estrutura. Mas parece que a física vai se tornando mais simples e mais unificada, à medida que diminui a escala para a qual olhamos. Existe uma escala de comprimento última, o comprimento de Planck, abaixo da qual talvez seja impossível definir o espaço-tempo. Acho que haverá um limite ao número de camadas de estrutura, e haverá alguma teoria última, que vamos descobrir, se tivermos inteligência suficiente."

Começamos então a falar dos trabalhos recentes sobre os "universos bebês" – bolhas no espaço-tempo. Para nós, criaturas grandes, o espaço-tempo é como o mar visto de um grande navio, liso e calmo. Visto de bem perto, porém, em escalas minúsculas, é feito de ondas e bolhas. E, em escalas extremamente finas, bolsões e bolhas de espaço-tempo podem formar-se aleatoriamente, surgindo e depois se dissolvendo. Os detalhes menos conhecidos da física de partículas sugerem que às vezes (rara, mas inevitavelmente) essas bolhas podem crescer, tornando-se um universo em escala plena.

Isso pode ter acontecido muito no instante imediatamente seguinte ao Big Bang. Na verdade, algumas das propriedades de nosso Universo podem ter sido criadas pela espuma do espaço-tempo que percorreu aqueles segundos infinitesimais, agitando-os. O estudo dessa possibilidade utiliza o "cálculo de wormholes", que trata das múltiplas bolhas borbulhantes possíveis (e das conexões entre elas, os "buracos de minhoca").

Fazendo uma média dessa espuma, no sentido matemático, e alisando um pouco suas propriedades, Hawking e outros vêm tentando descobrir se um universo final, bastante benigno, como o nosso, foi ou não consequência inevitável daquela turbulência inicial. Ainda não existe um consenso final sobre esse ponto entre os cientistas, e talvez nunca se chegue a um, na medida em que os cálculos são muito difíceis, guiados mais pela intuição do que por fatos. Decidir se eles prevêem alguma coisa ou não, de maneira significativa, é questão de opinião. Isso lembra o aforismo de Oscar Wilde segundo o qual, em assuntos de grande importância, o estilo sempre é mais importante do que a substância.

Se esse quadro da primeira fração de segundo estiver correto em qualquer medida, ou não, depende muito do conteúdo energético da espuma. A energia necessária para formar essas bolhas seria contrabalançada por uma energia oposta, negativa, que vem da atração gravitacional de toda a matéria contida na bolha. Se a pressão de dentro para fora contrabalançar a atração de fora para dentro (uma pressão, na realidade) da massa, então teremos um universo bastante parecido com o nosso: bastante moderado, com o espaço-tempo não sujeito a qualquer curvatura aguda -ou seja, o que os astrônomos descrevem como "plano".

Entre nós e os outros universos há o nada absoluto, no sentido exato, nenhum espaço ou tempo, nenhuma matéria, nenhuma energia.

Parece que é esse o caso em escalas relativamente minúsculas, como em nosso Sistema Solar, e o plano prevalece até mesmo na escala dimensional de nossa galáxia. Na realidade, o plano se mantém em escalas imensas, pelo que podemos enxergar por enquanto.

Ora, bolhas desse tipo ainda podem se formar. Um espaço-tempo inteiramente diferente poderia surgir de repente em sua sala de jantar. Ele começaria inimaginavelmente pequeno, então cresceria até atingir o tamanho de um balão – mas não diante de seus olhos, pois, por razões fundamentais, você não o poderia enxergar.

"Eles não se formam no espaço, é claro", disse Stephen. "Não significa nada indagar onde, no espaço, essas coisas ocorrem." Elas não ocupam espaço em nosso Universo, e sim em seus próprios universos, expandindo-se para formar espaços que não existiam antes.

"Depois que os fazemos, eles se separam de nós", eu disse. "Não deixam resquícios? Fósseis?"

"Acho que não poderia haver", respondeu Stephen.

"Como um filho ingrato que sai de casa e não escreve para os pais." Quando falo de imensidades, às vezes busco uma comparação humana. "Não se formariam em nosso espaço, mas em outro espaço-tempo."

Conversamos por algum tempo sobre algumas especulações a respeito do assunto que eu inseri em dois romances meus, "Cosm" e "Timescape". Usei Cambridge e o estilo científico britânico em "Timescape", publicado em 1980, antes de essas idéias se tornarem moeda corrente. Cheguei até elas em parte devido a algumas conversas sobre diversos assuntos que eu tinha tido com Stephen – todas bem disfarçadas nos livros, é claro. Eu tinha chamado esses espaços-tempos fechados de "universos-cebola", já que, em princípio, poderiam ter outros espaços-tempos fechados trancados dentro deles, e assim por diante. É uma sensação estranha quando um palpite seu acaba mostrando conter alguma substância -na medida, é claro, em que se pode dizer que são substanciais idéias tão etéreas quanto essas.

"Então eles se formam e depois desaparecem", refleti. "Somem. Entre nós e esses outros universos há o nada absoluto, no sentido exato: nenhum espaço ou tempo, nenhuma matéria, nenhuma energia." "Não pode haver nenhuma maneira de chegar até eles", disse a voz mecânica de Stephen. "O abismo entre eles e nós não pode ser transposto. Está além da física, porque é verdadeiramente nada – não é físico, em sentido algum.

A risada mecânica surgiu de novo. Stephen gosta de sentir a atração da reflexão filosófica e parece se divertir com a idéia de que universos são simplesmente uma dessas coisas que acontecem de tempos em tempos.

Seu enfermeiro apareceu para lhe fazer uma pequena limpeza. Ficar confinado a uma cadeira de rodas, sem poder se mover, é algo que cobra um preço aviltante de nossa dignidade, mas Stephen não demonstrou reação alguma à rotina diária de receber cuidados íntimos de outra pessoa. Quem sabe isso, para ele, até ajude sua mente a se libertar das imposições do mundo.

A secretária de Stephen saiu discretamente e perguntou se eu jantaria com ele no Caius College. Eu tinha pensado em comer no meu restaurante indiano favorito e depois simplesmente passear sozinho pelas ruas de Cambridge, porque adoro o ambiente de lá -mas concordei imediatamente. Jantar na mesa formal da faculdade é uma das experiências legendárias da Inglaterra. Eu me lembrava perfeitamente de cada jantar desses aos quais já fora, cujos convidados muitas vezes têm línguas mais afiadas do que facas.

Seguimos pelos caminhos arborizados das faculdades, cujas pedras cinzentas e madeira gasta ecoavam vozes e o guincho de bicicletas enferrujadas. Era um anoitecer com neblina, e a cadeira de rodas de Stephen saltitava sobre os paralelepípedos. Ele fazia questão de dirigi-la ele mesmo, embora seu enfermeiro viesse atrás, apreensivo. Nunca me ocorrera até que ponto essa obrigatoriedade de cuidar e ser cuidado 24 horas por dia pode ser cansativa. Algumas pessoas andavam atrás de nós, olhando para ele. "Não dê bola", disse a voz mecânica. "Muitos vêm aqui só para ficar me olhando."

POSTED BY SELETINOF AT 6:41 PM

MECÂNICA QUÂNTICA – Um desafio à intuição

Conferência de Solvay de 1927: Elétrons e Fótons. Nesta que foi talvez a mais famosa conferência, a recém formulada teoria quântica foi discutida pelos dois expoentes científicos da época: Albert Einstein e Niels Bohr (debate Einstein-Bohr). Acessado em:https://pt.wikipedia.org/wiki/Confer%C3%AAncia_de_Solvay

____________________________________________________________________________________________

Vicente Buonomano e

Ruy H. A. Farias

Instituto de Matemática

Universidade Estadual Campinas

____________________________________________________________________________________

Amecânica quântica – criada a partir dos anos 20 para explicar como são e como interagem os componentes do chamado micromundo – gerou uma grande controvérsia desde seu nascimento. Embora não haja dúvidas quanto à estrutura matemática da teoria, duas correntes de pensamento discutem seus fundamentos, ou seja, a maneira como ela interpreta omundo físico. No centro da discussão estão conceitos básicos para toda a física clássica, desenvolvidos intuitivamente pelo homem ao longo de sua história, mas que um dos pontos de vista conflitantes acredita não serem válidos na descrição do micromundo. As questões envolvidas nesse debate e os trabalhos teóricos ou experimentos com que os defensores das duas interpretações da teoria buscam as respostas representam uma das áreas mais efervescentes da física atual.

____________________________________________________________________________________________

Nossa postagem contém alguns acréscimos textuais e audiovisuais ao artigo original, porém, sem nenhum prejuízo para a ideias desenvolvidas no mesmo; pelo contrário, estes acrescentamentos contribuem para um maior esclarecimento das questões tratadas pelos autores. (FONTELES, R. C., Graduação e Pós-Graduação em Física – Universidade Federal do Ceará).

___________________________________________________________________________________________

Introdução

A mecânica quântica representa, sem exageros, a base científica sobre a qual se ergue uma parte importante da evolução tecnológica que hoje presenciamos. Suas leis físicas governam a estabilidade dos átomos e moléculas, assim como a interação da luz com tais elementos. Essa teoria foi elaborada, em sua essência, no decorrer das primeiras décadas do século XX, e estava praticamente formalizada, tal qual a conhecemos hoje. Embora seja extremamente bem-sucedida no que tange às confirmações experimentais de suas previsões, a teoria quântica vem suscitando, desde as suas origens, uma grande controvérsia no que diz respeito aos seus fundamentos. Essa controvérsia não envolve a estrutura matemática geral da teoria, estando basicamente centrada na maneira como a teoria é interpretada em termos físicos – ou, dizendo de outra maneira, na forma como a teoria descreve o mundo molecular, atômico e subatômico (o micromundo).

No centro da discussão estão alguns conceitos básicos herdados da física clássica e da intuição que o homem desenvolveu em sua vida cotidiana – conceitos como realismo e trajetória. Os próprios criadores da teoria quântica, muitos deles incluídos entre os nomes mais importantes da física do século XX, tinham pontos de vista bastante distintos com relação às conseqüências e mesmo ao status científico da nova teoria. As discussões foram longas e acaloradas, merecendo destaque os célebres debates entre Niels Bohor e Albert Einstein.

Em torno desses dois grandes referenciais da física da época formaram-se duas maneiras de interpretar a teoria. Não pretendemos, neste artigo, entrar nos detalhes dos vários pontos de vista diferentes existentes dentro de cada uma das correntes. Apresentamos apenas o cerne da discussão: a mecânica quântica de fato nos obriga a abandonar os chamados conceitos clássicos? Que tipo de imagem física podemos ter do mundo (no caso, o micromundo) em que vivemos? Estas são as questões básicas que vêm sendo discutidas, com certa efervescência, nos últimos 50 anos, e para as quais ainda não há respostas definitivas. O objetivo deste artigo é dar uma visão geral dessas questões.

Pode-se, grosso modo, agrupar as várias interpretações em duas grandes correntes. Bohr, Heisenberg, Born e Wigner são alguns dos nomes historicamente ligados ao que se convencionou chamar de interpretação de Copenhagen, porque Bohr trabalhava, com seus alunos, nessa cidade. Essa é considerada a interpretação oficial – ou ortodoxa – da mecânica quântica, por ser a usualmente encontrada nos livros textos, muito embora quase sempre de modo superficial, visto que a utilização prática da teoria não depende, em realidade, da sua interpretação. A escola de Copenhagen defende uma ruptura radical e revolucionária com os conceitos clássicos, com o que não concordam os integrantes da outra corrente, denominada interpretação clássica, e à qual estão historicamente ligados, Einstein, Schrödinger, De Broglie e Bohm.

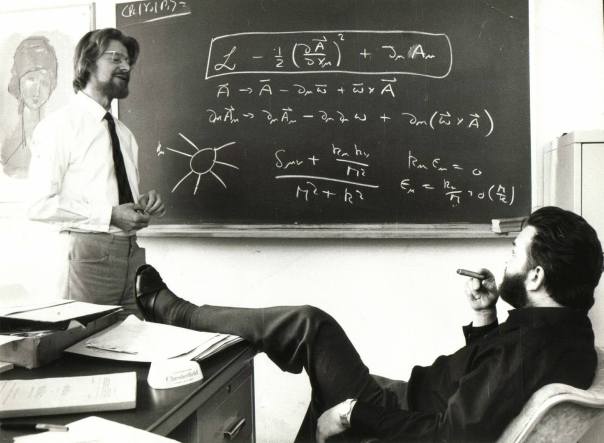

As controvérsias sobre os fundamentos da mecânica quântica se intensificaram muito na década de 1970, especialmente em função do trabalho do físico escocês John Stewart Bell (foto abaixo, à esquerda de Martinus Veltman, discutindo física no CERN), a quem dedicamos o artigo.

____________________________________________________________________________________

O trabalho de Bell, falecido prematuramente em outubro de 1990, aos 62 anos, representa a mais relevante contribuição aos debates sobre a natureza da realidade quântica feita nas últimas décadas. A situação atual é de relativa desordem, havendo uma enorme profusão de pontos de vista que, no entanto, podem ser razoavelmente enquadrados dentro das duas grandes interpretações.

Usando alguns exercícios de imaginação e analisando experimentos reais que visaram testar as descrições do micromundo feitas por cada uma das duas correntes, procuramos dar uma ideia, ainda que sem grande profundidade, das diferenças existentes entre elas. Alertamos, porém, que apresentaremos neste artigo, de certo modo, a nossa visão pessoal sobre o assunto, uma vez que os vários conceitos fundamentais envolvidos são em geral vistos com olhos bastante diversos em pontos de vista diferentes.

Os Conceitos Problemáticos

Os conceitos físicos envolvidos nos debates são de fundamental importância no contexto clássico, já que estão na essência das teorias que governam o chamado macromundo: a mecânica newtoniana, a gravitação e o eletromagnetismo. É fácil, portanto, imaginar as discussões geradas pela proposta de que tais conceitos fossem abandonados no caso da mecânica quântica. Evidentemente, dada a natureza fundamental dos conceitos clássicos, o resultado dessas controvérsias transcende os limites da mecânica quântica e torna-se relevante para toda a ciência.

Para facilitar a compreensão da controvérsia, em especial no caso dos menos familiarizados com a teoria quântica, procuraremos dar uma visão geral do significado de cada um dos conceitos envolvidos, apresentando-os já dentro do contexto dos debates.

A noção filosófica de realismo é inerente à concepção clássica do mundo. Realismo é a consideração de que os objetos (sejam planetas ou partículas microscópicas) existem por si mesmos e têm propriedades intrínsecas bem definidas, as quais não dependem do observador.

A questão que envolve o conceito de realismo pode ser apresentada – de forma simplificada – através do exemplo da moeda. Considerando-se o lançamento de uma moeda sob a luz da mecânica clássica (ligada ao macromundo), a probabilidade de obtermos cara ou coroa é, em cada moeda lançada, de 50%. Dentro da visão clássica, é possível argumentar que, se conhecêssemos absolutamente tudo acerca da moeda e de todas as forças envolvidas no lançamento, poderíamos prever exatamente o que resultaria: ou cara ou coroa. Isto é, se o estado do sistema fosse integralmente conhecido antes do lançamento, então o resultado poderia ser previsto com toda a certeza.

Explicando de outra maneira, vamos imaginar que, ao lançarmos duas moedas, obtemos cara em uma e coroa na outra. Segundo o ponto de vista clássico, alguma diferença existente entre um caso e outro fez com que as moedas caíssem de forma diferente. Tal diferença pode estar nas próprias moedas, nas forças que utilizamos para lançá-las ou em outro aspecto relacionado ao meio circundante. Assim, consideradas as mesmas condições de contorno, podemos dizer – pensando classicamente – que dois resultados diferentes devem ser o resultado de dois estados iniciais diferentes, conclusão que é válida para todas as teorias relacionadas ao macromundo.

Já na mecânica quântica – criada para explicar o micromundo – existem duas posições básicas a esse respeito. A escola de Copenhagen diz que as leis da natureza são intrinsecamente probabilísticas, o que significa que podemos ter diferentes resultados associados a estados iniciais absolutamente idênticos. De acordo com essa interpretação, existe um caos intrínseco: os resultados não são determinados por seus estados iniciais a não ser de modo probabilístico. Podemos lançar moedas absolutamente idênticas de uma maneira absolutamente idêntica e obtemos resultados diferentes.

A escola clássica, evidentemente, não concorda com tal ponto de vista. Essa corrente argumenta que o termo estado inicial identifica apenas um estado probabilístico (definido para um grande quantidade do mesmo objeto, como as moedas), existindo sempre uma subestrutura oculta que, se conhecida, nos permitiria prever exatamente como cairia cada moeda. Se todas as variáveis (incluindo essa imaginada subestrutura) fossem consideradas, a relação de causa e efeito seria preservada. Tais teorias foram denominadas teorias de variáveis ocultas ou, mais recentemente, teorias realistas.

O realismo é uma suposição implícita na física clássica e em toda teoria moderna, com exceção da mecânica quântica. Ao realismo também se associa a ideia de que o comportamento de um objeto é determinado por suas propriedades intrínsecas reais e por propriedades intrínsecas reais do ambiente em que ele se encontra. Para a interpretação de Copenhagen, porém, o mundo é não-realista. Para essa corrente, as propriedades dos corpos são propriedades apenas potenciais, que dependem do experimento realizado, ou seja, da observação que se está fazendo.

____________________________________________________________________________________________

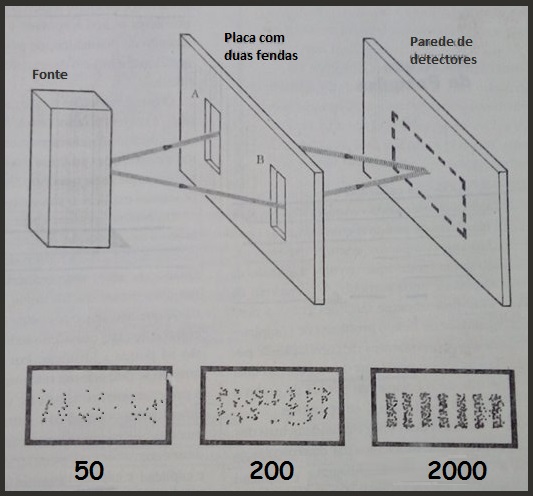

Figura 1. Experimento da dupla fenda. Uma fonte emite partículas microscópicas (elétron, por exemplo) em um espaço dividido por uma placa com duas fendas. Atrás da placa, a uma certa distância, temos um muro com detectores, que nos dirão onde cada partícula chegou. O que se observa é que, embora cada partícula seja detectada – num único detector – como se fosse um corpúsculo, após a incidência de um número grande de partículas, o conjunto das detecções forma um padrão típico de fenômenos ondulatórios. As figuras em detalhe mostram a aparência do padrão de interferência após 50, 200 e duas mil detecções. As linhas pontilhadas podem ser consideradas representações de trajetórias apenas sob o ponto de vista clássico.

____________________________________________________________________________________________

O conceito clássico de ‘localidade‘ baseia-se na premissa de que nenhum tipo de informação pode se propagar instantaneamente – ou, em sentido mais restrito, com velocidade superior à da luz – de um ponto a outro do espaço. Nos casos em que o comportamento de um objeto é afetado por outro objeto distante, a física clássica não admite que esse efeito esteja sendo transmitido instantaneamente de um a outro, acreditando que um certo intervalo de tempo não nulo é indispensável a essa transmissão. Uma situação com essas características é chamada de situação local.

Uma situação não-local, ao contrário, é aquela em que dois objetos distantes interagem instantaneamente, não havendo qualquer lapso de tempo entre causa e efeito. Situações não-locais já são admitidas por muitos no contexto das pesquisas teóricas e experimentais que envolvem os fundamentos da mecânica quântica. Alguns pesquisadores que acreditam em não-localidade, porém, não falam em transmissão instantânea de informações, preferindo pensar nos objetos como sendo partes de um mesmo todo, apesar de sua separação espacial. Outros acham difícil defender a noção de causalidade quando a não-localidade é assumida, já que causa e efeito ocorrem ao mesmo tempo, mas há quem não veja qualquer inconsistência neste fato. O conceito de localidade está no cerne de um dos grandes problemas em discussão, conhecido como o paradoxo de Einstein-Podolski-Rosen, identificado pela sigla EPR.

Na visão clássica, o conceito de partícula é bem claro, embora no contexto da física nunca tenha sido uma noção inteiramente bem definida. Usando uma imagem do macromundo para facilitar a apreensão da ideia básica, uma partícula seria algo como uma pequena pedra, que podemos dizer estar precisamente num determinado lugar e não em outro qualquer. Na mecânica clássica pode-se admitir que essa pedra esteja em uma determinada posição espacial e, simultaneamente, seja dotada de certa velocidade.

Na microfísica, entretanto, a interpretação de Copenhagen nos diz que uma partícula não pode ter, ao mesmo tempo, posição e velocidade bem definidas, ou medidas de forma precisa. Mas precisamente, essa visão da mecânica quântica afirma que se em um determinado experimento a posição da partícula é muito bem medida, então sua velocidade é bem pouco definida, e vice-versa (problema associado ao chamado ‘princípio da incerteza de Heisenberg‘, que não será abordado neste artigo). O significado exato dessa afirmação é outro ponto importante das controvérsias.

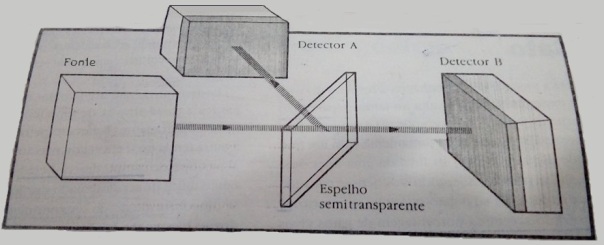

Discutiremos apenas o problema mais evidente associado à existência ou não de ‘trajetórias‘ que – classicamente – associamos às partículas. Esse problema foi levantado a partir do ‘experimento da dupla fenda’. Nesse experimento, uma fonte libera partículas microscópicas (elétrons, por exemplo) em um ambiente dividido por uma placa dotada de duas fendas paralelas, e além dessa placa situa-se uma parede composta de minúsculos receptores, que detectam a chegada de partículas em pontos definidos (figura 1). Se sabemos que uma partícula estava originalmente de um lado do aparelho e mais tarde foi detectada do outro lado, a conclusão óbvia da física clássica é a de que a partícula percorre alguma trajetória contínua bem definida, passando por uma das fendas. A interpretação de Copenhagen, porém, não aceita tal afirmação, negando a existência de trajetórias bem definidas para as partículas.

____________________________________________________________________________________

DO MICRO AO MACRO

__________________________________________________________

Visando modelar qualitativamente a transição de um sistema físico de seus estados microscópicos para suas propriedades macroscópicas, consideremos um sistema físico constituído por um grande número de partículas (átomos ou moléculas). Em princípio, então, assumindo a possibilidade de resolver o problema baseado nos nossos conhecimentos físicos, essencialmente precisamos de uma equação dinâmica, de movimento, para modelar tal sistema.

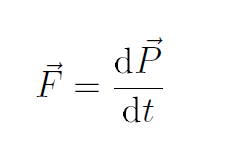

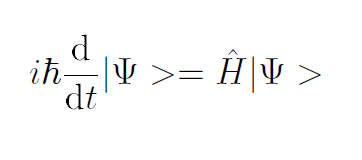

Na mecânica clássica, a segunda lei de Newton é uma equação de movimento utilizada para prever matematicamente o comportamento de um sistema físico ao longo do tempo, dado, claro, as condições iniciais. Na mecânica quântica, o análogo da lei de Newton é a equação de Schrödinger para sistemas quânticos (geralmente átomos, moléculas e partículas subatômicas sejam elas livres, ligadas ou localizadas), que descreve no tempo a evolução da função de onda do sistema (também chamada de “função de estado”).

Então, na escala do macroscópico, portanto, baseados na física clássica, temos a seguinte equação dinâmica para cada partícula, a qual nos permite descrever a órbita da partícula de uma forma determinística:

Agora, na escala do microscópico, devido a mecânica quântica introduzir um aspecto probabilístico intrínseco às partículas do sistema, a evolução do sistema físico é descrita por uma equação dinâmica baseada na probabilidade dos diversos estados possíveis de observação, pois, os objetos quânticos não possuírem propriedades reais intrínsecas, mas apenas propriedades potenciais. Assim, embora a descrição da evolução do sistema seja probabilística, sua descrição matemática dada pela Equação de Schrödinger é determinista:

Encontradas as equações de movimento, é necessário conhecermos então as forças envolvidas (ou potenciais) na interação das partículas entre si e com o meio externo. Essencialmente, temos as forças gravitacional e eletromagnética (e as forças forte e fraca se olharmos para as interações nucleares e subnucleares). Tendo, então, todos os ingredientes físico-matemáticos necessários para modelar o sistema físico, agora deveremos mensurar as grandezas do sistema.

.____________________________________________________________________________________

Áreas de Pesquisa

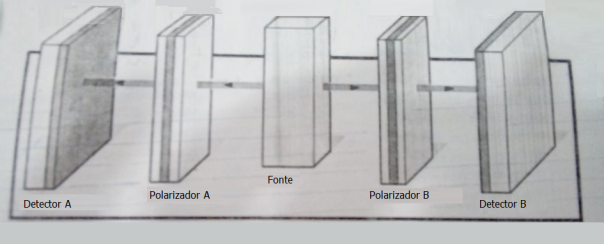

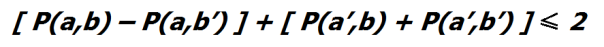

As discussões existentes a respeito dos conceitos clássicos estão enquadradas em algumas áreas de pesquisa com nomes às vezes bastante complexos, como o exemplo da ‘dupla fenda‘ (que envolve a questão da dualidade onda-partícula), o ‘paradoxo de EPR‘ (que abrange questões como a desigualdade de Bell, o problema da completeza e os experimentos de correlação de polarização) e o ‘problema de medida‘ (no qual se discute o colapso do pacote de ondas e o paradoxo do gato), entre outros.

Cada um dos conceitos fundamentais discutidos entre os adeptos das duas escolas – a clássica e a de Copenhagen – pode ser aplicado a uma ou mais dessas áreas de estudo. Neste artigo, discutiremos as três citadas aqui (o experimento da dupla fenda, o problema da medida e o paradoxo de EPR). Antes de abordarmos cada uma delas, porém, apresentaremos uma critica básica que frequentemente se faz contra a interpretação de Copenhagen.

Essa interpretação rejeita os três conceitos fundamentais (realismo, localidade e trajetórias bem definidas) que, até o advento da teoria quântica, eram paradigmas da Física. Bohr disse que o micromundo não é compreensível no sentido clássico ou que não há qualquer razão a priori para que o micromundo satisfaça a nossa intuição. Isso equivale a dizer que nossa intuição, que evoluiu durante milhões de anos de interação com o macromundo, não seria válida para imaginar o micromundo.

O posicionamento frequente da interpretação de Copenhagen sobre muitas questões é o de não respondê-las, afirmando que tais questões são inválidas, estão erradas. Para seus adeptos, a realidade física simplesmente não é compreensível no sentido sugerido pela questão. Essa escola rejeita os conceitos existentes, mas não os substitui por novos. Um posicionamento, então, que estabelece que certas questões são inválidas e que não se pode mais compreender a realidade física, não é de modo algum satisfatório. Ele nos deixa pouco à vontade e costuma ser acusado de dogmático, de não encorajar o questionamento e o desenvolvimento científico.

O que é relevante é saber se a interpretação é correta ou não. Isto é, se é realmente necessário abandonarmos certos conceitos e concepções estéticas sobre como gostaríamos que fosse o mundo físico para que possamos explicar o micromundo.

___________________________________________________________

Max Born

OBJETIVIDADE E SUBJETIVIDADE

___________________________________________________________

“Geralmente estamos convencidos de que entre as várias experiências, tanto pessoais como impessoais, existem algumas que compartilhamos com nossos colegas. Quando minha esposa tem uma dor de dentes, então isso é uma experiência ‘subjetiva’ dela. Não obstante eu possa imaginar sua dor e mesmo mostrar minha simpatia, não sinto essa dor. Mas se ela diz: ‘Veja como o céu está azul hoje’ e eu concordo, então fico convencido de que vemos o mesmo ‘azul’; esta é uma experiência ‘objetiva’, compartilhada com qualquer um que esteja olhando o céu. Apesar disso, não há realmente nenhuma diferença: você vê o ‘seu azul’, eu vejo o ‘meu azul’ e não há um meio de conseguir que eu veja o seu azul e você veja o meu. Como nos convencemos de que estamos vendo a mesma coisa?

Em primeiro lugar, somos feitos como todos os outros animais. O inseto, que voa em direção a uma flor, é atraído pela cor, pelo perfume e pela forma, da mesma maneira como todos os outros insetos. A mesma coisa ocorre aos seres humanos na vida quotidiana. Uma observação que impressione um de nossos sentidos, tal como a vista do azul do céu, é um caso relativamente raro; em geral, mais de um dos sentidos são impressionados de forma que, a observação das coisas que são perceptíveis aos diferentes sentidos, nos chega sem nenhum esforço consciente.

Mas, há um outro ponto importante: não obstante uma simples impressão sensorial seja completamente subjetiva e não comunicável, o mesmo não se dá quando temos duas impressões no mesmo órgão sensitivo.